Newsletter

Newsletter no. 41, März 2025

Editorial

Liebe Leserinnen und Leser,

Wie kann man Evaluationskompetenzen erwerben und weiterentwickeln? Wer kümmert sich darum? Und wie lässt sich das Bewusstsein für Evaluation stärken?

Die Nachwuchsförderung ist entscheidend – eine zentrale Herausforderung für die Zukunft der Evaluation, in der Schweiz und anderswo. Mit ihrem Stipendium unterstützt die SEVAL junge Menschen dabei, sich erste Werkzeuge und Erfahrungen in der Evaluation anzueignen. Lernen Sie die beiden Preisträgerinnen 2024 kennen.

Das digitalisierte Instrument des Wirkungsmodells steht nun zur Verfügung. Testen Sie es gerne und machen Sie es in Ihrem Umfeld bekannt. Es richtet sich nicht nur an Evaluierende, sondern auch an alle, die für die Konzeption von Massnahmen, Programmen oder Aktionsplänen verantwortlich sind.

Ein Blick über die Landesgrenzen hinaus kann inspirieren: Die OECD hat Empfehlungen erarbeitet, um die Evaluationspraxis zu fördern, und stellt eine umfassende Toolbox zur Verfügung. Zudem wird sie bald ein Benchmarking veröffentlichen, das die Situation in rund dreissig Ländern – darunter auch die Schweiz – vergleicht.

Viele weitere Themen erwarten Sie in diesem ersten Newsletter des Jahres – viel Vergnügen beim Lesen!

Laurent Crémieux,

Präsident SEVAL

Themen

- Aktivitäten und Mitteilungen der SEVAL

- Internationales

- Informationen aus den Arbeitsgruppen

- Agenda

- Publikationen

Aktivitäten und Mitteilungen der SEVAL

Jahreskongress 2025: Save the date!

Am 4. und 5. September 2025 findet der Jahreskongress der SEVAL in Fribourg statt. Er widmet sich dem Thema Evaluation von Innovation. Das Detailprogramm folgt. Tragen Sie jetzt schon die Daten in Ihr Agenda ein!

Für alle, die den SEVAL-Kongress 2024 verpasst haben oder die Erinnerung daran wecken möchten: Claudine Morier hat in der letzten LEGES-Ausgabe einen Rückblick dazu verfasst.

SEVAL Stipendium

Die SEVAL hat Danielle Isler und Mirjam Grünholz mit dem SEVAL-Stipendium zur Nachwuchsförderung ausgezeichnet. Porträts.

Danielle Isler

Wer bist du?

Mein Name ist Danielle Isler, ich bin eine Sozialwissenschaftlerin aus Zürich. Ich habe Ethnologie (B.A., Universität Zürich) und African Studies (M.A., Universität Basel) studiert. Zurzeit befinde ich mich in der Endphase meines Doktorats an der Universität Bayreuth, in dem ich die Konstruktion und Auswirkungen von De-facto-Apartheid in Post-Apartheid Südafrika untersuche. Im Laufe meines Doktorats durfte ich u.a. an der Universität Basel, der Berner Fachhochschule und der Humboldt-Universität zu Berlin unterrichten. Ich bin zudem in der diversitätsfördernden Bildungsarbeit tätig, halte Workshops, Vorträge und biete Beratungen an, um zu einer inklusiveren und gerechteren Gesellschaft beizutragen. Weiter bin auch eine begeisterte Musikerin und Künstlerin und stehe gelegentlich auf der Bühne.

Warum interessierst du dich für Evaluationen?

Evaluationen interessieren mich insbesondere deshalb, weil sie zukunftsorientiert und wegweisend sind, in dem Sinne, dass man die Gegenwart sowie die Vergangenheit eingehend analysiert, damit die Zukunft besser gestaltet werden kann. Abgeschlossene oder teilabgeschlossene Projekte aus einer Aussenstehenden – und ‘neutraleren’ Perspektive im Detail betrachten, Situationen und Prozesse verstehen, die Nützlichkeit, Durchführbarkeit oder beabsichtigten Ziele analysieren, um dann Verbesserungsvorschläge zumachen, Lob oder Ermutigung auszusprechen, damit Projekte kurz- mittel- oder längerfristig verbessert werden können. Genau dieser ‘Blick in die Zukunft’ ist es, den ich an Evaluationen so spannend finde und worin ich den Nutzen sehe. Als Evaluatorin würde ich sicherstellen, dass meine Arbeit (direkt oder indirekt) zur Gestaltung einer besseren Zukunft beiträgt. Und das ist für mich ein sehr schöner Gedanke.

Was erhoffst Du Dir vom Stipendium und dem CAS?

Als Noch-Promovierende bedeutet das SEVAL-ZUW-Stipendium für mich eine enorme finanzielle Entlastung, und ich bin nach wie vor sehr froh und dankbar, es erhalten zu haben. Von dem CAS erhoffe ich mir, theoretisches und praktisches Wissen zu erlernen, um in die Evaluationsbranche einsteigen zu können. Zudem hoffe ich, mich mit Menschen aus verschiedenen Evaluationsbranchen zu vernetzen und von ihrem Fachwissen und ihren Erfahrungen zu lernen. Ich glaube, dass es im Leben Phasen des Nehmens und des Gebens gibt. Ich hoffe, dass ich eines Tages in der Position sein werde, das weiterzugeben, was ich erhalten habe, zum Beispiel, dass ich eines Tages eine der Personen bin, die junge Evaluator*innen einführen und ihnen die ‚Evaluationswelt‘ ein Stück weit erklären darf.

Wie siehst Du Deine Zukunft in der Evaluationsgesellschaft in der Schweiz?

Da ich noch relativ neu dabei bin, kann ich noch nicht sagen, was auf mich zukommen könnte. Was ich allerdings weiss, ist, dass ich an der Evaluation von Projekten aller Art interessiert bin. Als Sozialwissenschaftlerin jedoch, die sich zunehmend mit Themen der Globalen Ungerechtigkeiten und allgemein mit politischen Fragen beschäftigt hat, würde mich die Evaluation von Projekten beispielsweise in der Entwicklungszusammenarbeit, Projekte zum Aufbau oder zur Förderung bilateraler Beziehungen und Projekte zur Bekämpfung struktureller Benachteiligung und zur Förderung von Vielfalt und Inklusion besonders reizen, da ich ein gewisses Fachwissen mitbringe. Ich würde mich darum auch sehr gerne in den Arbeitsgruppen engagieren, die sich mit diesen Themen befassen.

Mirjam Grünholz

Wer bist du?

Mein Name ist Mirjam Grünholz und ich bin SEVAL Praktikums-Stipendiatin. Als Sozialwissenschaftlerin ist es mein professioneller Wunsch, quantitative und qualitative Methoden zu verbinden und anzuwenden. Damit möchte ich national und international die nachhaltige Entwicklung von Menschen und Umwelt fördern, Forschung und Praxis zusammenführen, und durch Evaluationen und Analysen zu einem lehrreichen Übergang von Projektenden und -anfängen beitragen.

Warum interessierst du dich für Evaluationen?

Seit meinem Bachelorstudium gehören sozialwissenschaftliche quantitative und qualitative Methoden zu meiner beruflichen Ausrüstung. Zudem habe ich stets Tätigkeiten angestrebt, bei denen ich meine Begeisterung für Gesellschaft, Umwelt, (Daten-)Analyse und Internationales verknüpfen kann. Durch meine langjährige Erfahrung als Pfadfinderin liegt mir auch die Projektarbeit nahe. Auf diesem Weg haben sich mir folgende Fragen gestellt:

- Wie können Entscheidungsprozesse in Bezug auf Projekte und Programme durch Daten und Evidenz unterstützt werden?

- Wie werden Entscheidungen in der internationalen Zusammenarbeit getroffen unter Berücksichtigung lokaler Bedürfnisse, Anforderungen der Geldgeber*innen und unterschiedlichen Kulturen, Erfahrungen und Interessen?

- Wie können Projekte nachhaltig konzipiert und umgesetzt werden, sodass sie über den Projektzeitraum hinaus Bestand haben?

Im Rahmen des MAS in Internationaler Zusammenarbeit am NADEL/ETH Zürich habe ich festgestellt, dass Evaluationen von Projekten und Programmen genau solchen Fragen auf den Grund gehen. Sie tragen zu einem individuellen und organisationalen Lernprozess bei. Und sie können Projektteams, Geldgeber*innen und Auftraggeber*innen anleiten, zukünftige Projekte und Programme effizienter, effektiver und nachhaltiger auszugestalten. Ich bringe grosses Interesse für dieses Gebiet mit. Vertraut mit quantitativen und qualitativen Methoden, verfolge ich eine logische und analytisch geprägte Herangehensweise. Ich habe Freude an Details und möchte dabei aber auch das grosse Ganze verstehen.

Ich würde mich gern längerfristig in der Evaluation und der angewandten Forschung engagieren. Ich möchte mein analytisches Denken, meine Daten- und Methodenkenntnisse einbringen und ausbauen und mich dabei für eine ökologische, soziale und ökonomisch- nachhaltige Zukunft einsetzen.

Was erhoffst du dir vom Stipendium und dem Praktikum?

Das Stipendium erlaubt es mir, im Evaluationsbereich praktische Berufserfahrung zu sammeln. Ich erhoffe mir, von einem erfahrenen Team zu lernen und gleichzeitig mein eigenes Profil gezielt weiterzuentwickeln. Aufgrund dieser Erfahrung strebe ich an, künftig eine entsprechende berufliche Tätigkeit in diesem Bereich aufzunehmen.

Wie siehst du deine Zukunft in der Evaluationsgesellschaft in der Schweiz?

Ich sehe mich in Zukunft als Teil eines Teams, welches mit Begeisterung und Expertise hochstehende quantitative und qualitative Evaluationen und Analysen durchführt, idealerweise in der internationalen Zusammenarbeit oder im umweltsozialwissenschaftlichen Bereich. Längerfristig würde ich auch gern interessierten Menschen und Teams dieses Wissen weitergeben. Ich freue mich, dass die SEVAL mich auf diesem Weg begleitet.

Netzwerkveranstaltung vom 10.12.2024 zum Tool zur Entwicklung von Wirkungsmodellen

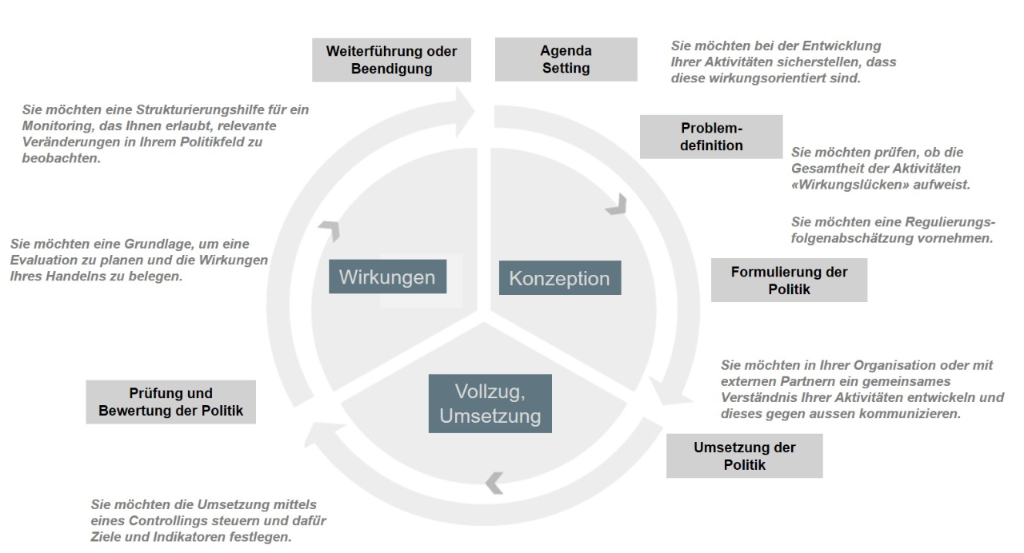

Am 10. Dezember 2024 fand eine Veranstaltung des Netzwerkes «Evaluation in der Bundesverwaltung» statt, bei der das neu entwickelte Tool zur Erstellung von Wirkungsmodellen vorgestellt wurde. Die Veranstaltung war für alle SEVAL-Mitglieder offen und stiess auf reges Interesse. Dabei wurden sowohl die Anwendungsmöglichkeiten als auch der Nutzen des Tools für den gesamten Politikzyklus aufgezeigt. Das Tool und der dazugehörige Leitfaden richtet sich an alle, die eine wirkungsorientierte Perspektive im Politikzyklus einnehmen möchten – von der Planung einer Politik bzw. staatlichen Massnahmen bis zu deren Evaluation.

Darstellung: Nutzung des Tools im Politikyzklus

Die Veranstaltung begann mit zwei Präsentationen aus der Perspektive von Auftraggebern (BAG) und Auftragnehmern (PrivatePublicConsulting GmbH, PPC) von Evaluationen. Sie erläuterten die Anwendung und Erwartungen an Wirkungsmodelle im Politikzyklus sowie spezifisch bei der Vergabe und Durchführung von Evaluationen. Dabei wurden unter anderem die Rolle von Wirkungsmodellen bei der Zieldefinition von staatlichen Massnahmen und bei der Wirkungsmessung diskutiert. Auch praktische Erfahrungen, Herausforderungen, Potenziale sowie Good Practices aus der Sicht der Auftraggebenden und Auftragnehmenden wurden thematisiert.

Im Anschluss wurden die Entstehungsgeschichte sowie der Zweck des neuen Tools und des begleitenden Leitfadens vorgestellt. Die Teilnehmenden hatten danach die Möglichkeit, sich in vier parallelen Workshops intensiv mit dem Tool auseinanderzusetzen. Besonderes Augenmerk lag auf den Funktionen des Tools zur Unterstützung des gesamten Politikzyklus sowie auf den Modulen zur Planung und Wirkungsmessung.

Die Veranstaltung stiess auf sehr positive Resonanz. Die Teilnehmenden brachten wertvolle Verbesserungsvorschläge ein, die zur Weiterentwicklung des Tools beitragen sollen. Besonders betont wurde der Wunsch, dass Änderungen künftig in beide Richtungen zwischen den Modulen übertragen werden können, was eine flexiblere Bearbeitung ermöglicht. Weitere Anregungen betrafen die Einführung einer erweiterten Exportfunktion, die es den Nutzern erleichtert, die erstellten Inhalte in verschiedenen Formaten zu speichern. Zudem wurde vorgeschlagen, dass die Inhalte je nach Zielgruppe angepasst und somit gezielt auf unterschiedliche Bedürfnisse eingegangen werden kann. Schliesslich wurde auch der Wunsch geäussert, dass einzelne Elemente im Tool flexibel ein- oder ausgeblendet werden können, um eine benutzerfreundlichere Handhabung zu gewährleisten.

Das Tool steht nun allen interessierten Personen und Institutionen offen zur Verfügung:

Eine Übersetzung des Tools ins Französische und Englische bzw. des Leitfadens ins Französische steht demnächst bereit.

Die Finanzierung der Nutzungsgebühr wird von mehreren Institutionen unterstützt, darunter BJ, BAFU, BAG, BSV, DEZA, SBFI, SECO, BFE und TPF. Die Finanzierung der Übersetzung des Tools ins Französische und Englische wird von der SEVAL und Innosuisse übernommen.

Weitere Verbesserungsvorschläge können jederzeit über die Seite des Tools eingereicht werden. Nach der ersten Nutzungsphase ist eine Umfrage unter den Nutzerinnen und Nutzern geplant, um die Weiterentwicklung des Tools weiter voranzutreiben.

Weiterführende Informationen zur Veranstaltung: Netzwerkveranstaltung vom 10.12.2024

Prix SEVAL: Nur noch wenige Tage, um Ihre Arbeit einzureichen!

Die Frist für die Einreichung einer Arbeit mit einem Bezug zur Evaluation für den Prix SEVAL 2025 läuft am 2. April 2025 ab! Zögern Sie also nicht länger und senden Sie Ihre Arbeit jetzt an secretariat@seval.ch.

Der Prix SEVAL richtet sich an alle Personen, die kürzlich eine Arbeit mit einem Bezug zur Evaluation verfasst haben: einen wissenschaftlichen Artikel, der einen Beitrag zur Weiterentwicklung von Theorie und Praxis der Evaluation oder zur Verwendung von Evaluation liefert, oder einen Evaluationsbericht, der sich durch einen innovativen Ansatz oder Methoden auszeichnet und andere Teams inspirieren könnte.

Dieser Preis wurde von der SEVAL geschaffen, um die wissenschaftliche Auseinandersetzung mit Evaluationen zu fördern. Es können sowohl wissenschaftliche Arbeiten wie auch Evaluationsstudien ausgezeichnet werden. Die Arbeiten können auf Deutsch, Französisch, Italienisch oder Englisch verfasst sein.

Seit 2012 wurden Arbeiten zu diversen Themen prämiert, so z.B. zur (Nicht-)Evaluation von E-Government-Projekten, zu den wirtschaftlichen Auswirkungen von regionalen Naturparks, zu Erhebungsinstrumenten körperlicher Aktivität, zu Big Data in der Evaluation, zur Messung der Wirksamkeit von Entwicklungsprojekten, zur Beeinflussung von Evaluatoren und Evaluatorinnen in der Schweiz oder zum Beitrag von Evaluationen zur Qualität des Diskurses in den Medien.

Der Prix SEVAL wird einmal jährlich anlässlich des SEVAL-Jahreskongresses verliehen. Der Preis ist mit CHF 3000.– dotiert und beinhaltet auch die Veröffentlichung eines Beitrages in LeGes.

Die offizielle Ausschreibung, das detaillierte Reglement, sowie weitere Informationen zum Prix SEVAL sind auf der SEVAL-Webseite aufgeschaltet. Die SEVAL und die Mitglieder der Jury freuen sich auf Ihre Arbeiten!

Internationales

Jahrestreffen der OECD-Expertengruppe für Evaluation

Am 6. Februar fand das 6. Jahrestreffen der OECD-Expertengruppe für Evaluation statt, an dem auch die Schweiz teilnimmt. Laurent Crémieux war vor Ort und stellte die Verbindung zur SEVAL sicher. Die OECD hat 2022 Empfehlungen verabschiedet, die Regierungen dazu ermutigen, die Evaluation von öffentlichen Politiken zu institutionalisieren und zu fördern. Diese Expertengruppe ermöglicht es, die Praktiken der verschiedenen Länder auszutauschen, zu vergleichen und die Umsetzung der Empfehlungen zu verfolgen.

Die OECD hat ein Instrument für die Praxis entwickelt – das „Public Policy Evaluation Toolkit“ –, das Verwaltungen dabei unterstützt, ihre Kompetenzen im Bereich der Evaluation zu verbessern und ihre Kapazitäten zu stärken. Ziel ist es auch, die eigenen Stärken und Schwächen besser zu verstehen, indem man sich von den Praktiken und Trends anderer OECD-Mitgliedsländer inspirieren lässt. Dieses Toolkit dient als Unterstützung bei der Umsetzung der Empfehlungen von 2022. Die OECD trägt somit zur weiteren Institutionalisierung der Evaluation und zur Entwicklung einer Evaluationskultur bei, welche die Entscheidungsprozesse und die Gestaltung öffentlicher Politiken stärkt. Das Ziel ist es, wirksamere Massnahmen zu ergreifen und das Vertrauen in staatliche Institutionen zu festigen.

Die Empfehlungen finden Sie unter dem Link zu den OECD Legal Instruments sowie im Public Policy Evaluation Toolkit.

Ein Ländervergleich mit rund dreissig Staaten solle demnächst veröffentlicht werden… Wir sind gespannt darauf !

Die Webseiten der Evaluationsgesellschaften in der Schweiz und weltweit finden Sie hier.

Informationen aus den Arbeitsgruppen

Die neue SEVAL-Arbeitsgruppe zur künstlichen Intelligenz in der Evaluation hat ihre erste Sitzung abgehalten

Die SEVAL hat eine neue Arbeitsgruppe! Am 19. Februar trafen sich rund zwanzig Personen zum Thema Künstliche Intelligenz (KI) in der Evaluation, um die Aktivitäten der neuen Arbeitsgruppe zu starten. Bei diesem ersten Austausch konnten sich die Mitglieder der Gruppe kennenlernen und ihre Erwartungen und Interessen austauschen. Es wurden mehrere Ideen diskutiert, insbesondere der Austausch praktischer Erfahrungen (welche Instrumente sollten in welchem Kontext und mit welchen Vorsichtsmassnahmen verwendet werden?), Fragen des Datenschutzes und der Zuverlässigkeit der Ergebnisse, die Entwicklung von Standards oder eines «Code of Conduct» sowie Überlegungen dazu, wie KI unseren Alltag als Auftraggebende/Auftragnehmende verändert. Nach dieser ersten Sitzung werden sich die Mitglieder der Arbeitsgruppe in Kürze erneut treffen, um ihre konkreten Aktivitäten zu planen.

Bei diesem Treffen hat die Arbeitsgruppe auch ihre Verantwortlichen bestimmt: Carole Probst (econcept) und Kerstin Schwarz (FMSystO) werden sich die Co-Leitung dieser Arbeitsgruppe teilen.

Nach verschiedenen Veranstaltungen und Initiativen anderer Arbeitsgruppen zu diesem Thema wurde der Bedarf an einem gemeinsamen und koordinierten Ansatz zum Thema Künstliche Intelligenz in der Evaluation deutlich. Aus diesem Grund hatte die SEVAL Anfang des Jahres einen Aufruf zur Interessenbekundung an ihre Mitglieder gerichtet, um Personen zu finden, die sich in dieser Arbeitsgruppe engagieren möchten.

Der Vorstand der SEVAL freut sich über das grosse Interesse an diesem Thema und wünscht der neuen Arbeitsgruppe viel Erfolg bei ihren Aktivitäten!

Agenda

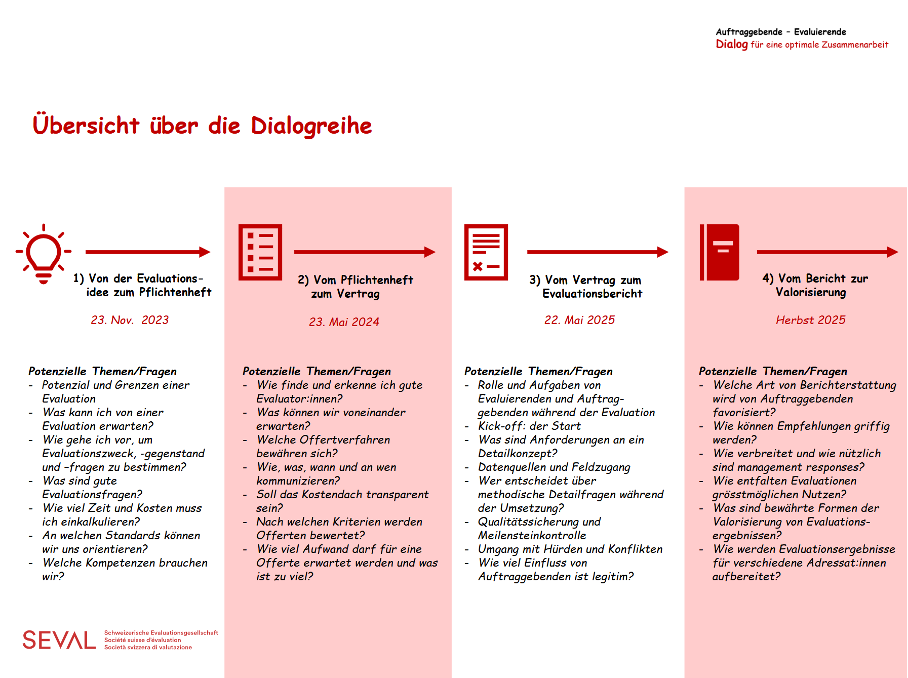

Dialogveranstaltung 3 “Vom Vertrag zum Evaluationsbericht“

Donnerstag, 22. Mai 2025

17.00-19.00 Uhr, mit anschliessendem Apero

Veranstaltungsort: Zentrum für universitäre Weiterbildung, Universität Bern, Gebäude UniS, Schanzeneckstr. 1, Raum A-119 (UG).

Anmeldung bitte bis 12.05.2025 an: evaluation.llc@unibe.ch

Weitere Informationen entnehmen Sie bitte dem Flyer. Wir freuen uns auf einen weiteren interessanten und lebhaften Austausch!

Erkenntnisse aus den beiden ersten Dialogen (Teil 1 «Von der Evaluationsidee zum Pflichtenheft», Teil 2 «Vom Pflichtenheft zum Vertrag»):

In LeGes ist ein Werkstattbericht über die erste und ein Werkstattbericht über die zweite Dialogveranstaltung erschienen. Das Video mit Teilnehmendenstimmen zum ersten Dialog kann HIER angeschaut werden!

Günter Ackermann, Qualität und Evaluation, Leitung AG Kompetenzen der SEVAL

Stefanie Krapp, Bereich Evaluation ZUW/Uni Bern, Mitglied der AG Kompetenzen

SEVAL@BFH: Was is Evaluation im Q-Bereich?

Donnerstag, 3. April 2025

14.15-17.45 Uhr, mit anschliessendem Abendessen

Mehr dazu hier.

Zur Erinnerung: wenn Sie als Mitglied der SEVAL an einer Veranstaltung teilnehmen möchten und anschliessend einen kurzen Beitrag dazu veröffentlichen, welche Erkenntnisse Sie aus dieser Veranstaltung gewonnen haben, können Sie für Ihre Transportkosten, Unterkunft und Registrierung eine Entschädigung von max. CHF 1’000.- beantragen. Ihren schriftlichen Beitrag veröffentlichen wir im Newsletter. Bitte kontaktieren Sie in der Phase der Vorbereitung Ihrer Reise das SEVAL-Sekretariat secretariat@seval.ch

Weitere News und Veranstaltungen finden Sie fortlaufend hier.

Publikationen

Befragung: Welchen Einfluss haben Politikevaluationen und welche Faktoren sind dabei entscheidend?

Trotz der hohen Dichte an Politikevaluation wissen wir erstaunlich wenig über deren Auswirkungen und welche Faktoren wirklich einen Unterschied machen. In einer internationalen Studie wollen Valérie Pattyn und Pirmin Bundi mehr darüber erfahren, um die Evaluationspraxis zu stärken und die Qualität der Politik zu verbessern. Das Projekt wird durch einen Veni-Zuschuss des niederländischen Forschungsrats (NWO) und des Bundesamts für Gesundheit finanziell unterstützt.

Waren Sie im Zeitraum 2018-2022 an einer oder mehreren Evaluationen beteiligt? Wenn ja, laden wir Sie ein, an einer kurzen Befragung über Ihre Erfahrungen teilzunehmen. Das Ausfüllen des Fragebogens wird etwa 15 Minuten in Anspruch nehmen. Im Gegenzug erhalten wir wertvolle Informationen, die uns dabei helfen, die Wirksamkeit von Evaluationen besser zu verstehen. Sie können an der Befragung teilnehmen, indem Sie auf diesen Link klicken.

Vielen Dank im Voraus für Ihre Mitarbeit!

Valérie Pattyn (Universität Leiden) & Pirmin Bundi (Universität Lausanne)

Hinweise auf Publikationen

Die Rubrik Publikationen bietet eine Plattform, um auf Neuerscheinungen zum Thema Evaluation oder auf Publikationen von Seval-Mitgliedern (Evaluationsberichte, Bücher, Artikel in Büchern oder Fachzeitschriften etc.) aufmerksam zu machen. Entsprechende Hinweise nimmt die Redaktion jederzeit gerne entgegen: secretariat@seval.ch