Editorial

Les groupes de travail sont le moteur de la SEVAL. Leurs nombreuses activités témoignent de leur dynamisme. Dans cette Newsletter, vous découvrirez des comptes-rendus inspirants des événements de ces derniers mois. Vous y trouverez également un portrait du premier lauréat de la bourse pour encourager la relève en évaluation.

Le congrès annuel est l’événement phare de la SEVAL et l’occasion de nous retrouver. Le comité d’organisation a concocté un programme passionnant plein de découvertes. A l’honneur, la communication, thème qui nous préoccupe toutes et tous afin de rendre notre démarche et nos résultats plus accessibles. Inscrivez-vous, venez nombreux et diffusez l’information autour de vous !

Laurent Crémieux

membre du comité de la SEVAL

Thèmes

- Activités et communications de la SEVAL

- Internationale

- Formations et formations continues

- Informations de la part des groupes de travail

- Agenda

- Publications

Activités et communications de la SEVAL

Congrès 2024 : Les inscriptions sont ouvertes !

Cette année, le congrès annuel de la SEVAL, coorganisé avec le GREVAL, porte le titre « Image et perception de l’évaluation. Sommes-nous trop technocrates ? » et aura lieu les 29 et 30 août. Ce thème sera abordé lors de la journée du vendredi 30 août. Découvrez le programme !

L’évaluation n’est pas toujours perçue comme un instrument d’amélioration de l’action publique. Qui n’a jamais entendu qu’elle ne servait à rien et qu’elle était coûteuse ? Ces clichés peuvent-ils être dépassés ? Il semblerait qu’une partie d’entre eux provienne de la manière parfois trop technocratique dont les évaluateur·rice·s communiquent avec les différentes parties prenantes, y compris les membres de groupes cibles, les utilisateur·rice·s potentiel·le·s et le grand public.

Grâce à des présentations de personnes maîtrisant à la fois l’évaluation et la communication, nous explorerons des stratégies visant à améliorer la compréhension de l’évaluation auprès des personnes qui ne sont pas spécialisées dans cette matière. Le programme laisse également de la place à la discussion et à l’échange d’expérience entre praticien·ne·s de l’évaluation et toutes les autres personnes intéressées.

L’après-midi du jeudi 29 août inclura en plus des traditionnels ateliers méthodologiques, un side-event destiné aux évaluateur·rice·s émergent·e·s, ainsi que des discussions en tandem entre un·e évaluateur·rice émergent·e et un·e évaluateur·rice expérimenté·e. Cette année, l’offre en ateliers est imposante et diversifiée. Chacune et chacun pourra participer à quatre ateliers en allemand, en français ou bilingues.

Bourse relève 2024

La bourse SEVAL pour l’encouragement de la relève entre dans sa deuxième phase

La bourse SEVAL ayant été attribuée pour la première fois l’année dernière, les jeunes professionnels intéressés peuvent cette année encore postuler pour la bourse CAS et/ou la bourse de stage.

Vous connaissez de jeunes talents de la relève ? Alors n’hésitez pas à les inviter à postuler pour la bourse !

Plus d’informations ici

***

Bourse relève 2023

Lauréat de la bourse relève 2023

La bourse de relève 2023 a été attribué à Rasmané Sina afin de suivre un CAS à l’IDHEAP. Le jury a reçu une dizaine de demandes.

– Rasmané Sina, quel est votre parcours ?

Assistant de cours d’économie à l’université de Genève, je suis très actif dans les questions d’analyse de politiques économiques de développement, la gestion de projets et programmes, l’évaluation des politiques publiques, en passant par ma formation de base universitaire qui est l’analyse Macroéconomique du développement, les politiques économiques et sociales et surtout les méthodes mixtes (quantitatives et qualitatives) appliquées aux sciences sociales.

– Pourquoi avez-vous posé votre candidature pour la bourse ? Quelle est la valeur ajoutée pour vous ?

Ma candidature pour la bourse de la société suisse d’évaluation (SEVAL) est motivée pour deux raisons. Premièrement pouvoir accéder à une formation très avancée et très pointue en évaluations de politiques publiques du prestigieux institut des hautes études en administration publique (IDHEAP) et deuxième pouvoir d’intégrer la SEVAL pour apporter ma contribution en compétences techniques et à la diversification des méthodes d’évaluation des politiques publiques à la fois en Suisse tout comme sur le plan international.

– Quelle est votre expérience du CAS à l’IDHEAP ?

La formation au CAS est de riche expérience pour moi avec un renforcement de compétences sur la méthodologie et les techniques d’évaluation des politiques publiques et la gestion des projets et programmes. La formation a aussi connu l’intervention de plusieurs acteurs du milieu universitaire et professionnel. Ce qui a permis une formation beaucoup plus professionnelle et pratique et surtout appliquée avec plusieurs outils très avancées pour une évaluation rigoureuse des politiques publiques, projets et programmes à la fois quantitative et qualitative. La formation a été axé sur des cas pratiques et des exemples réels d’évaluation des politiques publiques, des projets et programmes à la fois en Suisse qu’à l’international. Elle m’a permis une bonne connaissance des différents modèles d’évaluation et surtout avec une bonne dose de la démarche scientifique en évaluation. Ce qui permet de formuler de recommandions très pertinentes pour l’aide à la décision en milieu privé tout comme dans le secteur public à la suite d’une conduite d’évaluation des politiques publiques, des projets et programmes. J’ai pu travailler sur l’évaluation pratique d’un programme de la coopération internationale et du développement.

– Comment voyez-vous votre avenir dans la communauté suisse de l’évaluation ?

Un avenir professionnel épanoui dans cette communauté. Avec cette formation, combinée à mes expériences professionnelles en évaluation des projets et programmes, je serai dans une très bonne posture pour les mandats d’évaluations des originations internationales pour les questions sociales, environnementales et du développement. Avec la SEVAL, c’est une formation continue avec la prise en compte des nouvelles recherches sur les évaluations des politiques publiques. Ce qui permet une maîtrise parfaite non seulement des questions d’évaluation de politiques économiques et sociales au niveau suisse mais aussi celles de la coopération internationale et du développement axés sur les grands projets et programmes de développement de la politique suisse à l’étranger. C’est aussi une belle occasion d’intégrer un grand réseau mondial de professionnels et d’expert en évaluation de politiques publiques, projets et programmes pour le renforcement et la construction d’une expertise en évaluation.

Internationale

Compte rendu

IV. Forum mondial de l’évaluation

Rabat – 26, 27 et 28 février 2024

Le IVe Forum mondial de l’évaluation, intitulé « Mener une pratique d’évaluation progressive et contemporaine », s’est déroulé du 26 au 28 février dernier à Rabat, au Maroc.

Le Forum était organisé par l’Organisation internationale pour la coopération en évaluation (OICE) et EvalPartners, en collaboration avec l’Association Marocaine d’Évaluation (AME), les agences onusiennes ainsi que le Ministère des affaires étrangères Finlandais et l’Institut allemand pour l’évaluation du développement (DeVAL). Il s’est déroulé principalement en anglais, et dans une moindre mesure en français et arabe également.

Le IVe Forum mondial de l’évaluation offrait l’occasion à EvalPartners et à la communauté mondiale de l’évaluation d’élaborer un nouvel EvalAgenda 2030, d’approfondir et de faire avancer l’évaluation, y compris l’élargissement et l’optimisation des partenariats, et la mise en œuvre de la résolution de l’ONU (A/RES/77/283) pour l’évaluation nationale des objectifs du développement durable (ODD), adoptée en 2023.

Le lundi, des ateliers pré-forums ont été organisés en parallèle sur des aspects plus méthodologiques :

- Évaluation menée par le pays : maximiser l’utilité, l’utilisation et la qualité

- Évaluation pour relier les priorités nationales aux ODD

- Le rôle des VOPE (Voluntary Organizations for Professional Evaluation) dans la promotion de la résolution des Nations Unies

- Quelles sont les réponses aux défis méthodologiques de l’évaluation des politiques publiques ?

- Comment éviter les écueils de la normalisation ? Fondements méthodologiques pour une meilleure diversité en évaluation

- Pratiques d’évaluation transformatrices, progressives et innovantes

- Analyse des contributions : cadrer l’évaluation et éviter les pièges

- Intelligence artificielle générative (IA)

Le mardi, la plénière d’ouverture rassemblait des officiels marocains. Il en est ressorti les éléments principaux suivants :

- L’importance de l’évaluation pour la responsabilité parlementaire et la prise de décision basée sur des données probantes.

- La nécessité d’une approche participative qui intègre la voix des citoyen·ne·s dans le processus d’évaluation.

- Les défis liés à la qualité des données et aux ressources limitées, qui entravent l’efficacité de l’évaluation.

- La valeur de l’institutionnalisation de l’évaluation dans les mécanismes de gouvernance et de prise de décision.

- L’engagement envers l’amélioration continue et l’adaptation des méthodes d’évaluation pour répondre aux besoins en constante évolution.

La discussion en plénière portait sur la transformation de l’évaluation pour tenir compte des réalités mondiales et nationales. Il en est ressorti :

- L’importance d’adopter des approches systémiques et des théories de changement transformatives.

- La nécessité d’une évaluation plus inclusive et participative.

- Le potentiel de la technologie et de l’innovation pour enrichir l’évaluation.

- Les défis de la transformation de l’évaluation et les stratégies pour les surmonter.

- Les opportunités offertes par une collaboration internationale accrue et une perspective globale.

Les sessions parallèles de l’après-midi portaient globalement sur trois thématiques :

- Plusieurs portaient sur les objectifs du développement durable:

- Évaluation des ODD et renforcement des capacités d’évaluation du gouvernement

- La valeur de l’évaluation dans un monde en transformation : implications pour la réalisation des ODD dans le cadre d’un développement dirigé par les pays

- Évaluations nationales des ODD : un appel urgent à l’action

- Examens nationaux volontaires et égalité des sexes : où sont les preuves ?

- Une session traitait du rôle des parlementaires dans l’institutionnalisation de l’évaluation des politiques. Six ans après la Déclaration de Colombo, la session a abordé les mesures prises par les parlements du monde entier pour mettre en œuvre la Déclaration de Colombo et institutionnaliser l’évaluation, les résultats obtenus, les défis rencontrés et les leçons apprises.

- Deux sessions concernaient la décolonisation / les relations Sud-Sud :

- Décoloniser la pratique de l’évaluation

- Lignes directrices Sud-Sud pour une évaluation transformatrice

Le dernier jour, une discussion en plénière était prévue sur la direction à définir pour EvalAgenda 2030. Des représentant·e·s d’agences onusiennes et de bailleurs de fonds (UNSDG, Unicef, UNFPA) et d’autres institutions internationales (EvalPartners, IEAC) ont réexaminé le rôle de l’évaluation face aux défis contemporains et tenté de donner une nouvelle orientation pour contribuer efficacement à l’atteinte des ODD. Le panel a souligné l’urgence d’adopter des approches d’évaluation innovantes et orientées vers l’action pour soutenir les efforts mondiaux visant à atteindre les ODD.

Les panélistes ainsi que l’assistance du Forum considèrent globalement l’évaluation non seulement comme un outil de mesure et de soutien à la prise de décision, mais bien plus comme un catalyseur de changement, un moyen de donner voix aux sans-voix, et un pilier pour construire des sociétés plus résilientes et inclusives, dont l’EvalAgenda 2030 en est le symbole.

Cette dernière journée également, des sessions étaient organisées en parallèle :

- L’une portait sur les leçons à tirer des expériences d’institutionnalisation des capacités et des fonctions d’évaluation à l’échelle mondiale

- Une autre tentait de faire un bilan après 8 ans depuis le lancement des ODD

- Un panel portait sur la question de savoir dans quelle mesure une approche d’évaluation Made in Africa est applicable à d’autres régions.

Une dernière discussion en plénière portait sur la résolution des Nations Unies, sur la voie à suivre pour mettre en œuvre et agir en conséquence de la résolution et sur le rôle des différents acteurs pour la faire avancer.

Finalement, un dernier panel portait sur la professionnalisation de l’évaluation. Organisé et modéré par Claudine Morier, membre de la SEVAL, vice-présidente du RFE pendant 4 ans, nouvellement représentante du RFE auprès de l’OICE, ce panel rassemblait des représentant·e·s d’associations nationales d’évaluation du Luxembourg, du Sénégal, du Maroc et du Mexique. Il interrogeait la nécessité de professionnaliser l’évaluation (pourquoi) ainsi que les processus et les modalités organisationnelles et pratiques (comment).

Il a permis de mettre en lumière diverses expériences et leçons apprises dans le processus unique à chaque pays vers une évaluation plus structurée et professionnalisée. En abordant des exemples concrets et des stratégies éprouvées, le panel a illustré les discussions qui animent aujourd’hui la communauté de l’évaluation. Les défis de l’institutionnalisation des capacités d’évaluation sont nombreux, notamment la résistance au changement, le manque de ressources, et la tension entre capacité individuelle versus systémique. Les opportunités permettent toutefois de contrer, en partie, certains de ces défis, telles que l’innovation technologique, la collaboration internationale via des réseaux tels que le RFE notamment et la promotion d’une culture de l’apprentissage et de l’amélioration continue.

Mon avis sur le Forum

C’est la première fois que je participais à ce Forum, porté par des organisations internationales et onusiennes que les évaluateur·rice·s en développement connaissent depuis longtemps.

La première chose qui m’a frappée, c’est que, bien que nous parlions d’une même discipline, que nous utilisions en partie les mêmes méthodes (à l’exception des évaluations d’impact quasi expérimentales propres à ce domaine et d’autres méthodes peu utilisées en Suisse telle que l’analyse de contribution ou le outcome harvesting par exemple) et que nous utilisions les mêmes critères, l’approche se révèle très différente. Les débats étaient rythmés d’interventions alarmistes et interventionnistes. Les évaluateur·rice·s en développement considèrent en effet qu’ils·elles ont un rôle à jouer dans la définition et la mise en œuvre des politiques publiques nationales et internationales et se sentent en partie responsable de l’échec de l’atteinte des ODD, objectifs autour desquels tournait tout l’événement.

Deuxièmement, la faible participation (une centaine de participant·e·s environ) n’était pas à la hauteur de l’événement. Les conférences européennes ou africaines par exemple rassemblent quatre à cinq fois plus de personnes. Cela est dû notamment à des difficultés de financement qui illustrent un changement observé de manière plus globale par de nombreuses organisations régionales et internationales ces dernières années. Cela a eu pour conséquence un certain entre-soi ainsi qu’une invisibilisation des VOPE.

Finalement, ma participation a tout de même été enrichissante. Même si comparaison n’est pas raison, le Réseau francophone de l’évaluation en est ressorti grandi à tous les niveaux. La capacité de mobilisation de personnes-clés du RFE, son professionnalisme dans l’organisation du Forum International Francophone de l’Évaluation et la plus-value des outils développés à destination de ses membres, comme l’outil diagnostic en matière de professionnalisation, démontrent la pertinence de l’engagement de la SEVAL dans ce réseau. Il est évident que le fait de collaborer avec des partenaires d’un même espace linguistique facilite les choses, bien que les différences culturelles soient énormes entre les trois continents rassemblés au sein du RFE. La collaboration au niveau mondial est, de fait, encore plus ardue et ambitieuse, et la participation à ce type d’événement probablement plutôt destinée aux personnes actives dans l’évaluation du développement.

Claudine Morier

Co-fondatrice de laoulia

Les sociétés d’évaluation en Suisse et dans le monde peuvent être consultées ici

Formations et formations continues

Invitation à des manifestations publiques dans le cadre de l’International Program for Development Evaluation Training (IPDET) à l’Université de Berne

Le célèbre programme international de formation continue en évaluation aura lieu du 15 au 26 juillet 2024 à l’Université de Berne. Nous attendons plus de 180 participant·e·s d’environ 65 pays qui apprendront ensemble les bases en évaluation et les thèmes actuels de l’évaluation, échangeront et réseauteront. Les personnes intéressées sont cordialement invitées aux manifestations publiques suivantes :

15.7., 9:00-10:30h : IPDET Opening

Le maire de la ville, Alec von Graffenried, inaugurera officiellement le programme IPDET onsite 2024. Vous en saurez plus sur les participant·e·s et sur le Core Course on Fundamentals of Evaluation, avec lequel le programme débute. La pause café qui suivra sera l’occasion de faire connaissance et d’échanger avec les participant·e·s et les enseignant·e·s.

17.7., 18:30-19:30h : Impact Happy Hour

Échange informel organisé par Coopération Globale : Une lutte forte contre la pauvreté – une Suisse forte (cooperationglobale.ch) sur l’évaluation et la mesure de l’impact au-delà de la coopération au développement. Discussion sur les obstacles, les meilleures pratiques et les possibilités de soutien par Coopération Globale.

24.07., 14:00-15:00h : Fishbowl Discussion sur l’institutionnalisation de l’évaluation dans une perspective globale – Résultats de l’Europe, de l’Amérique du Nord et du Sud, et de l’Asie.

Ensuite, café et gâteaux dans le jardin et IPDET World Exhibition avec des items issus des différentes cultures et pays des participant·e·s.

25.07., 19:00-20:00h : Forum ouvert sur l’évaluation de l’action humanitaire organisé par l’Association ukrainienne d’évaluation (UEA) et le Réseau d’apprentissage actif pour la responsabilité et la performance dans l’action humanitaire (ALNAP).

Passez nous voir, participez à la discussion et vivez l’esprit unique de l’IPDET !

Lieu: Université de Berne, Centre de formation continue universitaire, bâtiment UniS, Schanzeneckstr. 1, Auditorium S003, Berne

Contact: Dr Stefanie Krapp, Head of IPDET, stefanie.krapp@unibe.ch

Le prochain CAS en évaluation débute en mars 2025

au Centre de formation de l’Université de Berne (Zentrum für universitäre Weiterbildung (ZUW))

Les diplômé·e·s du CAS en évaluation 2023 lors de la journée de clôture

Le CAS en évaluation s’adresse aux personnes qui commandent des évaluations ou qui sont responsables de la gestion d’évaluations. La structure, les contenus et les formats didactiques ont été remaniés pour la mise en œuvre en 2025. Il aborde des questions fondamentales telles que : qu’est-ce que l’évaluation et qu’est-ce qui la distingue d’autres approches, quelles sont les étapes d’une évaluation et qu’est-ce qui fait partie de la gestion de projets d’évaluation, que sont les modèles d’impact et quel rôle jouent-ils dans les évaluations, quels sont les designs et les méthodes d’enquête qui peuvent être utilisés dans les évaluations, qu’est-ce qui fait une bonne évaluation et comment peut-on promouvoir son utilisation ?

Le CAS en évaluation dure un an (de mars 2025 à mars 2026), comprend 7 modules et une journée de clôture. Il donne droit à 15 crédits ECTS. Le travail du CAS est axé sur une utilité pratique maximale pour les participant·e·s.

Plus d’informations et inscription : ICI

Contact : Dr Stefanie Krapp, responsable du domaine de l’évaluation au ZUW, stefanie.krapp@unibe.ch

Jeunes évaluateurs/trices : La SEVAL et le ZUW octroient une bourse pour la participation au CAS : Bourse – SEVAL

Voici ce que disent les diplômé·e·s du CAS 2023 :

“Le CAS nous a permis d’aborder le processus d’évaluation sous différentes perspectives et d’apprendre à mettre en œuvre les bases théoriques dans la pratique concrète. Je peux ainsi appliquer directement ce que j’ai appris dans mon travail”, Julia Rickenbacher, interface

“Tout le monde veut de l’impact, et pourtant la plupart se contentent de bons espoirs au lieu de preuves. Le cours CAS m’a montré des moyens de traquer l’impact”, Philip Gehri, DVIGS

Cours de formation continue en classe inversée sur les

Bases des évaluations pour sa propre pratique professionnelle, 31.10., 21.11., 12.12.2024

Centre de formation continue universitaire (ZUW) de l’Université de Berne en coopération avec la Haute école fédérale de formation professionnelle (IFFP)

Les évaluations – au-delà des rituels, des mécanismes de contrôle automatisés et des processus standardisés de gestion de la qualité – apportent une grande utilité, par exemple pour les processus de développement, d’apprentissage et d’enseignement. Le cours montre comment cette promesse peut être tenue grâce à une planification sérieuse et réaliste de l’évaluation, adaptée aux besoins spécifiques et aux intérêts en matière d’information.

Le cours suit le concept didactique de la “classe inversée” (flipped classroom). Cela signifie que les contenus sont élaborés à la maison et que l’application pratique a lieu pendant les 3 jours de présence. Le cours peut être pris en compte pour le CAS en évaluation.

Plus d’informations et inscription : ICI

Enseignants : Prof. Dr Lars Balzer, Dr Veronique Eicher (IFFP)

Contact : Dr. Stefanie Krapp, responsable du domaine de l’évaluation au ZUW, stefanie.krapp@unibe.ch

The International Program for Development Evaluation Training (IPDET) at the University of Bern

This is IPDET

The International Program for Development Evaluation Training (IPDET) is an executive training program that aims to provide decision makers, managers and practitioners with the tools and skills to commission, manage and implement policy, program or project evaluations at local, national, regional, and global levels as well as to use those evaluations for decision-making. IPDET sets a great focus on practice and provides a diversified approach for audiences from different organizations and sectors who play different roles in the evaluation process. This is unique in the evaluation training sector and gives the participants differentiated perspectives on evaluation and connects individuals worldwide.

The program is a collaborative effort between three partners: The Center for Continuing Education (ZUW) at the University of Bern, Switzerland, the Center for Evaluation (CEval) in Saarbrücken, Germany, and the Independent Evaluation Group of the World Bank (IEG). This partnership brings long-standing roots in development evaluation and training as well as strong faculty with on-the-ground experience.

Since 2021, IPDET is a core implementing partner of the Global Evaluation Initiative (GEI) and receives funds especially for scholarships and Global Outreach activities from GEI funding partners. GEI is an inclusive global partnership committed to developing country-owned, sustainable monitoring and evaluation (M&E) frameworks and capacities to promote the use of evidence in public decision-making, enhance accountability, and achieve better results.

Based on IPDET´s Evaluation Capacity Development Strategy, IPDET consists of three different streams of capacity building activities, which are framed by overarching community building activities:

On-Site Program | Bern, Switzerland | Fundamentals of evaluation are taught during the one-week Core Course, followed by one week of consolidation and specialized workshops. Furthermore, due to its onsite character, it is a central networking place for the IPDET Community.

Online Workshops | Adapting to the constrains of the Covid-19 pandemic IPDET developed an online program stream in 2020. Each workshop is conducted throughout one week and covers a specialized evaluation topic. The online workshops combine synchronous and asynchronous learning.

Global Outreach | Since 2021 IPDET is expanding its activities across the globe, guided by its IPDET’s Global Outreach Strategy, ensuring that trainings and guidance can better be tailored to the needs of specific audiences in different regions. The activities are both, demand and supply driven and target decision makers and practitioners in national governments, civil society and development organizations, parliamentarians and their scientific staff, trainers for evaluation, and young and emerging evaluators.

Community Building | To strengthen and connect the community, IPDET engages the onsite participants in specific networking activities and implements online activities, like the Kick-Off and Closing Event, social gatherings, and technical tools, like the IPDET Listserv, the IPDET eLearning platform, and the IPDET CoSMOS (Community server – a memorable online society).

IPDET`s 2023 participants

Participation numbers | The IPDET On-Site program 2023 attracted 171 individuals in total, 76 of them have been awarded a scholarship. During the first week, a total of 119 participants attended the Core Course and for the second week IPDET welcomed 146 participants who attended one to two workshops.

Countries and regions | Participants coming from ‘Europe and Central Asia’ accounted for the highest attendance share during the entire On-Site program (35%), and especially during the workshop week. In the Core Course they were closely followed by participants from Sub-Saharan Africa.

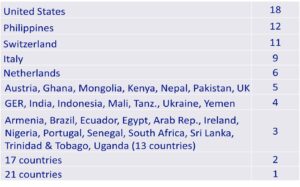

Participants came from 70 different countries:

Table 1: Countries with highest attendance in 2023 (onsite and online)

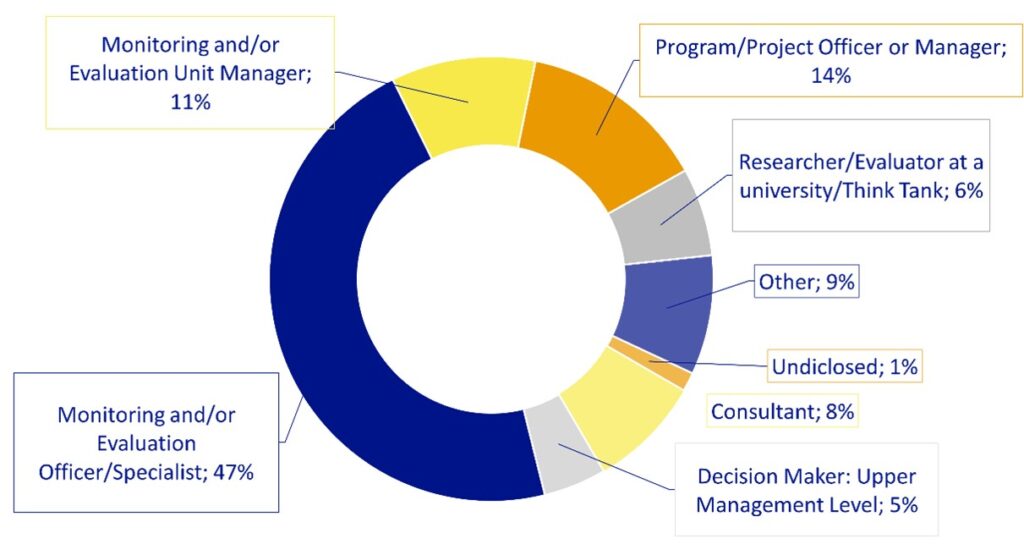

Job Position in M&E | Regarding the job position that participants held at the time of the On-Site program it can be stated that half of the participants worked as ‘M&E Officers or Specialists’, while the second largest category was represented by those working as a ‘Program/Project Officer or Manager’ (14%). The third largest group was ‘M&E Unit Managers’ (11%). A small proportion of the overall participants reported working as a ‘Consultant’ (8%) or a ‘Researcher/Evaluator at a University/Think Tank’ (6%), and even fewer participants (only 5%) indicated to be working as ‘Decision Maker at the Upper Management Level’.

Figure 2: Job positions of participants

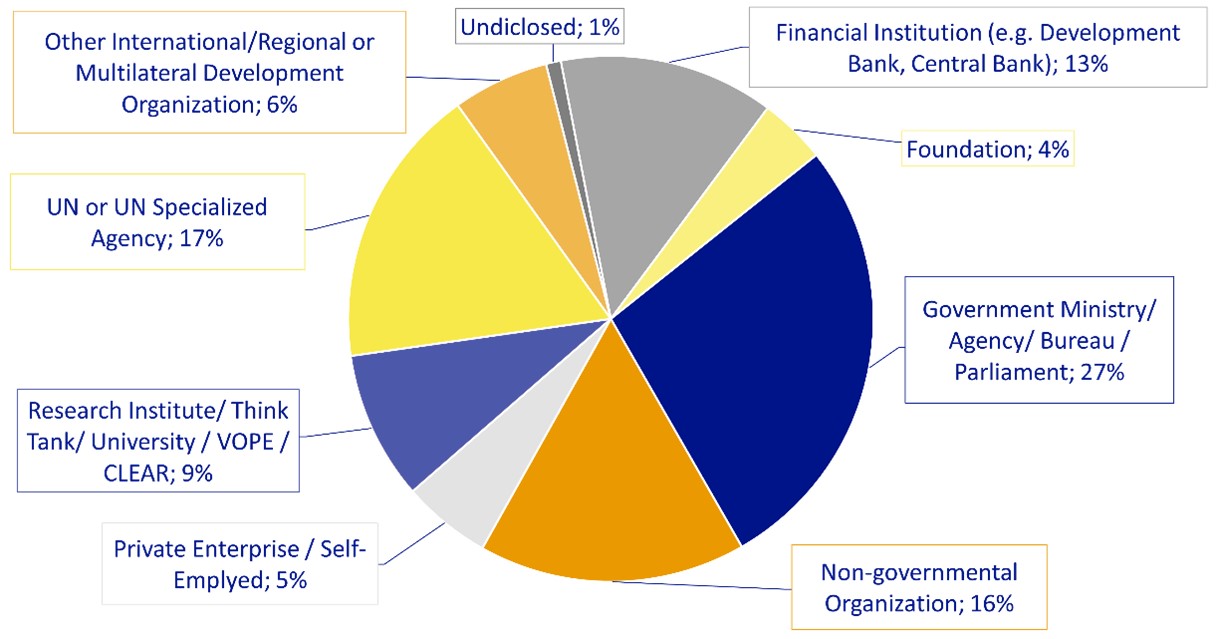

Type of organization | 27% of participants worked for the ‘Government, Ministry, Agency or Bureau’, representing the largest categorical group; followed by those from an ‘UN/UN specialized agency’ (17%), a ‘Non-governmental organization’ (16%), and a ‘Financial institution‘ (13%).

Figure 3: Types of organizations participants are working for

IPDET`s take aways and plans to utilize the gained knowledge

And or enroll in this year`s online workshop:

More information: International Program for Development Evaluation Training | IPDET

Contact: Dr. Stefanie Krapp, Head of Program, stefanie.krapp@unibe.ch

Vous trouvez d’autres manifestations sur notre site web

Informations de la part des groupes de travail

Échange d’expériences de la SEVAL sur l’efficacité de la coopération internationale

29 février 2024 au Centre de formation continue universitaire (ZUW) de l’Université de Berne

Les groupes de travail SEVAL Coopération internationale et Compétences ont organisé, en collaboration avec le Contrôle fédéral des finances (CDF), un échange passionnant le 29 février 2024 avec :

- Dr. Jörg Faust, directeur de l’Institut allemand d’évaluation de la coopération au développement (DEval)

- Simone Ledermann, responsable du Contrôle parlementaire de l’administration (CPA) de la Suisse

- Silvana Hogg, responsable du service Evaluation et Controlling de la DDC

- Reto Thönen, Service Evaluation et Controlling de la DDC

- Stefanie Krapp, responsable de l’International Program for Development Evaluation Training (IPDET) de l’Université de Berne

Le nombre élevé de participant·e·s à la manifestation (45 personnes) montre le grand intérêt porté au thème de l’efficacité de la CI.

De gauche à droite : Stefanie Krapp (IPDET / Université de Berne), Jörg Faust (DEval), Silvana Hogg (DDC), Simone Ledermann (CPA), Reto Thönen (DDC), Kimon Schneider (NADEL EPFZ), Mathias Rickli (CDF), Laurent Crémieux (SEVAL / CDF).

1. Le rôle de l’Institut allemand d’évaluation de la coopération au développement (DEval)

Après le mot de bienvenue de Laurent Crémieux, représentant du comité SEVAL, et l’introduction de Stefanie Krapp (ZUW/Uni Berne) et Mathias Rickli (CDF), Jörg Faust a fait un exposé introductif sur la genèse, les objectifs et le but du DEval et son utilité pour le public. Le DEval a été créé en 2012 par le ministère fédéral allemand de la Coopération économique et du Développement (BMZ). La mission principale du DEval est d’analyser et d’évaluer les activités de la coopération allemande au développement – de manière indépendante, orientée vers la pratique et sur la base de connaissances scientifiques. L’institut agit ainsi à l’interface de la politique, de la science et de la pratique, avec pour objectif global de mettre à disposition de la coopération au développement des preuves utiles. Une autre tâche consiste à développer les méthodes et les normes d’évaluation existantes afin d’améliorer la pratique de l’évaluation. De plus, le DEval s’emploie à renforcer les capacités d’évaluation dans les pays partenaires de la coopération allemande au développement. Enfin, il soutient la diffusion des connaissances générées par les évaluations. Cela doit permettre d’encourager les processus d’apprentissage et de faciliter les décisions dans la coopération au développement. La présentation de Jörg Faust se trouve ici. Pour plus d’informations sur le DEval, cliquez ici.

Pour Jörg Faust, les possibilités et les limites de la mesure de l’efficacité dans la CI sont influencées par les quatre aspects principaux suivants :

- Du côté de l’offre, il existe en principe de très nombreuses possibilités de mesure de l’efficacité, de plus en plus grâce à des méthodes sophistiquées ou à leur combinaison et à l’utilisation de nouvelles technologies (Big Data, IA, etc.). L’élément décisif sera de savoir dans quelle mesure les unités d’évaluation disposent des ressources nécessaires (temps, capital humain, finances, capital organisationnel) ou peuvent les obtenir ou les développer.

- Du côté de l’utilisation, beaucoup dépend du cadre institutionnel qui influence l’utilisation de preuves indépendantes et utiles (normes d’évaluation, processus d’évaluation, alimentation et mise en œuvre des recommandations).

- Tant du côté de l’offre que du côté de l’utilisation, l’évaluation sera de plus en plus confrontée à un équilibre entre les exigences accrues d’orientation vers les partenaires et celles d’orientation vers les intérêts des pays donateurs.

- Concurrence accrue : l’évaluation est un fournisseur sur le marché très concurrentiel des données probantes.

Jörg Faust (DEval)

2. Evaluation de la mesure de l’efficacité de la CI suisse

En janvier 2022, les Commissions de gestion des Chambres fédérales (CdG) ont chargé le Contrôle parlementaire de l’administration (CPA) d’évaluer la mesure de l’efficacité dans la CI. Le CPA n’a pas examiné lui-même l’efficacité de la CI, mais s’est plutôt penché sur la manière dont les trois unités administratives responsables de la CI – la Direction du développement et de la coopération (DDC), le Secrétariat d’Etat à l’économie (SECO) et la Division Paix et droits de l’homme (AFM) – mesurent l’efficacité de leurs interventions à l’aide d’évaluations et en rendent compte.

Simone Ledermann a présenté la situation de départ, l’approche méthodologique et les résultats de cette évaluation du CPA:

L’évaluation s’est focalisée sur 3 aspects : 1) la qualité des évaluations et des outils, 2) l’utilisation des évaluations pour le pilotage et la reddition des comptes, 3) le coût des évaluations.

- Ad 1) Les points forts de la qualité se situent au niveau des cahiers des charges et des résumés et conclusions des rapports, ce qui est utile pour le pilotage. Les faiblesses se situent au niveau de la présentation des méthodes et des résultats des rapports, ce qui est problématique pour la reddition des comptes.

- 2) Les évaluations indépendantes portant sur des thèmes généraux sont utilisées pour le pilotage stratégique et les recommandations font l’objet d’un suivi systématique. En revanche, les évaluations externes de projets sont utilisées pour le pilotage opérationnel des activités, mais sans suivi systématique des recommandations. Il n’est pas possible de dire si les objectifs de la stratégie de CI sont atteints, car les évaluations externes ne mesurent pas explicitement la réalisation des objectifs et il n’y a pas de bilan systématique dans le rapport final.

- Ad 3) Les coûts de l’évaluation sont jugés globalement transparents. Mais moins de 2,5 % des coûts du projet sont en moyenne consacrés à une évaluation externe, ce qui est plutôt bas en comparaison internationale. Il n’y a pas de lien entre la qualité des évaluations externes et leur coût.

La présentation de Simone Ledermann se trouve ici et le rapport du CPA est publié ici.

Simone Ledermann (CPA)

Silvana Hogg a résumé les points de vue et les mesures des trois unités de la CI (DDC, SECO, AFM) concernant le rapport du CPA : Leurs services d’évaluation ont eux-mêmes identifié des lacunes en matière de qualité et des besoins d’amélioration et considèrent que les recommandations du CPA/CPP-E vont dans le bon sens et peuvent être mises en œuvre. Pour améliorer la qualité des évaluations, il convient notamment d’intensifier la collaboration entre les services d’évaluation, de réviser les outils d’évaluation (DDC), de renforcer les capacités d’évaluation des responsables de programme par des modules de formation et de rendre obligatoire le suivi des recommandations d’évaluation. L’amélioration de la reddition des comptes doit être obtenue, entre autres, par la révision des pratiques de publication et de la méthodologie du taux de réussite, l’introduction d’un taux commun pour la DDC/SECO, davantage d’évaluations ex post et un nouveau système numérisé (DDC) qui enregistre systématiquement des déclarations plus représentatives et plus compréhensibles sur l’efficacité de la CI.

La présentation de Silvana Hogg se trouve ici

Silvana Hogg (DEZA)

3. discussion de groupe sur la mesure de l’efficacité de la CI

Lors de la discussion de panel finale animée par Kimon Schneider (NADEL EPFZ), Jörg Faust (DEval), Simone Ledermann (CPA), Reto Thönen (DDC) et Stefanie Krapp (IPDET) ont échangé avec le public sur des questions spécifiques concernant l’impact de la CI et le rôle de l’évaluation, entre autres quelles sont les possibilités et les limites de la mesure de l’impact dans la CI, quelles sont les capacités nécessaires et à quels niveaux, comment surmonter le paradoxe micro-macro face à la complexité, actualités et tendances dans l’évaluation de thèmes complexes (financement climatique, numérisation, IA/big data, compétences nécessaires, etc.)

Les éléments clés de la discussion ont été la remarque qu’il n’y a pas vraiment de limites méthodologiques à une bonne mesure de l’impact. Ce qui est important et constitue un défi, c’est la présence d’une “pensée évaluative”, en particulier dans l’administration publique, et les nouvelles compétences nécessaires pour pouvoir gérer les applications BigData et IA.

Par ailleurs, l’organisation de la fonction d’évaluation dans les agences de développement a été discutée. Selon DEval, il est clairement établi qu’une fonction d’évaluation décentralisée est plus exposée à des problèmes de qualité qu’une fonction d’évaluation centralisée forte. Les panélistes étaient unis dans leur regard critique sur l’exigence politique populaire, mais déconnectée de la réalité, de vouloir mesurer le travail des agences de développement publiques à l’aide d’un taux de réussite des projets mis en œuvre.

Les panélistes de gauche à droite : Jörg Faust (DEval), Simone Ledermann (CPA), Reto Thönen (DDC),

Stefanie Krapp (IPDET) et le modérateur Kimon Schneider (NADEL / EPFZ).

Pour la SEVAL SA Compétences : Stefanie Krapp

Pour le CDF : Mathias Rickli

Pour la SEVAL AG IZA : Kimon Schneider

Série de dialogues SEVAL entre évaluateurs/-trices et mandants

2ème séance de dialogue : “Du cahier des charges au contrat”.

23.05.2024, 17:00-19:00h, Centre de formation continue universitaire/Uni Berne

Organisateur : SEVAL GT Compétences et standards

Une bonne collaboration dès le départ entre évaluateurs/-trices et mandants est un facteur de succès important pour une évaluation réussie et efficace. Dans le cadre de la manifestation de la SEVAL “Formation et formation continue en évaluation – Quo Vadis ?” en avril 2022, la qualification des mandataires a été identifiée comme un besoin urgent pour garantir cela. Le GT Compétences de la SEVAL organise donc une série de dialogues en quatre parties pour promouvoir l’échange entre les mandants et les évaluateurs, améliorer leur collaboration et développer les compétences à différentes étapes d’une évaluation :

- De l’idée d’évaluation au cahier des charges, 23.11.2023

- Du cahier des charges au contrat, 23.05.2024

- Du contrat au rapport d’évaluation, novembre 2024

- Du rapport à la valorisation, printemps 2025

Participant·e·s et focus sur les contenus

Lors de la deuxième réunion de dialogue, 11 évaluateurs/-trices et 8 mandants ont échangé leurs points de vue sur les aspects centraux des appels d’offres et des offres, notamment : Comment trouver et reconnaître de bons évaluateurs/-trices, types et procédures d’appel d’offres, communication pendant la phase d’offre, qualité et volume des offres, critères d’évaluation, négociations contractuelles, clarification du mandat.

Après une rétrospective de la dernière séance de dialogue (voir le rapport d’atelier dans LeGes 35, 2024, 1), les évaluateurs et les mandants d’évaluations ont d’abord rassemblé en groupes séparés les défis de cette phase, chacun dans sa perspective, puis en ont discuté de manière transpersonnelle. Sur la base des multiples défis, les participants ont identifié les points de tension et développé des pistes d’action.

Lien avec les standards SEVAL

En introduction au dialogue, Christian Rüefli, responsable du groupe de travail Standards de la SEVAL, a attiré l’attention sur les Standards SEVAL qui ont une importance particulière dans la phase entre le cahier des charges et le contrat. Lors de l’appel d’offres et de la planification d’une évaluation, des décisions sont prises et des bases sont posées qui sont importantes pour la qualité d’une évaluation. Il s’agit alors de concevoir les contenus, le concept, la méthodologie, la procédure et la gestion de projet d’une évaluation de manière à ce qu’ils puissent remplir au mieux leur objectif et répondre autant que possible aux standards. Bien qu’en principe tous les critères soient pertinents à chaque phase, il s’agit, dans la phase entre le cahier des charges et le contrat, de mettre particulièrement en évidence les critères suivants :

- A1 Ouverture aux résultats et impartialité

- A4 Orientation vers l’utilisation

- A6 Garantie des compétences requises

- B1 Clarification de l’objet, du but, des questions d’évaluation et de l’utilisation

- B4 Convention d’évaluation

- B5 Concept d’évaluation approprié

- C5 Documentation de l’évaluation

Lors de la conception d’une évaluation, les mandants et les évaluateurs/-trices peuvent utiliser concrètement les standards de différentes manières : Mandants lors de l’appel d’offres, évaluateurs lors de l’établissement de l’offre, les deux parties lors du lancement du projet.

Défis dans la phase entre le cahier des charges et le contrat

Pour le mandant :

- Délimitation de l’objet de l’évaluation

- Formuler de “bonnes” questions d’évaluation auxquelles il est possible de répondre avec le budget disponible.

- Gérer son “instinct” et son intuition lors de la prise de décision.

- Prestataires sans compétence spécifique en matière d’évaluation (bureaux de développement organisationnel, instituts de conseil ou de recherche sans spécialisation correspondante)

- Équipes d’évaluation présentées dans l’offre avec de nombreux collaborateurs compétents, mais qui ne participent pas tous à l’évaluation.

Pour les évaluateurs/-trices :

-

- Les attentes des mandants sont souvent trop élevées et les questions d’évaluation trop vastes par rapport au plafond de coûts donné.

- Difficulté à gérer les attentes implicites

- Situation de concurrence souvent difficile à évaluer dans la procédure d’offre, mais l’effort à fournir pour l’élaboration des offres est assez élevé.

- Le manque de compétences des mandants peut impliquer que le prix et non la qualité soit au premier plan lors de l’évaluation des offres.

- Délais trop courts pour la présentation des offres

- Pas de possibilité de demander des précisions lors du processus d’offre

- Pas d’utilisation cohérente des critères d’évaluation des offres

- Refus succincts ou incompréhensibles quant au contenu par rapport à la charge de travail que représente l’établissement d’une offre

- Retrait d’appels d’offres pendant la phase d’offre

Champs de tensions résultant des défis

- Cadre prédéfini : Les évaluateurs/-trices saluent le fait que le cadre d’une évaluation soit clair. Alors que les mandants ayant des compétences insuffisantes en matière d’évaluation peuvent représenter un défi pour les évaluateurs/-trices, par exemple parce que les directives sont irréalistes, la professionnalisation croissante des mandants a aussi des inconvénients : lorsque les mandants formulent l’évaluation souhaitée de manière trop détaillée sur la base de leur propre expertise et que, par exemple, les sources de données, les méthodes d’enquête, la taille de l’échantillon, etc. sont déjà prédéfinies, il reste peu de marge de manœuvre. Pour les évaluateurs/-trices, il est important de pouvoir faire valoir leur expertise dans la discussion et de pouvoir développer et proposer eux/elles-mêmes un design d’évaluation approprié.

- Evaluation des offres: plus les offres soumises sont différentes, plus il est difficile pour les donneurs d’ordre de procéder à une évaluation comparative. D’autre part, il est intéressant pour les donneurs d’ordre que différentes approches méthodologiques soient proposées et qu’ils puissent faire leur choix parmi elles.

- Flexibilité pour les adaptations : Il est difficile de déterminer et de calculer, dès la phase de l’offre, l’ampleur des enquêtes à effectuer pendant toute la durée d’une évaluation pluriannuelle, alors que l’on ne sait pas encore comment l’objet de l’évaluation évoluera au fil des ans et quelles nouvelles questions d’évaluation en découleront. Les évaluateurs/-trices souhaitent que les donneurs de mandat leur indiquent clairement que les approches d’évaluation adaptatives sont les bienvenues et qu’ils leur indiquent comment gérer cette tension entre budgétisation contraignante et adaptabilité.

- Procédure d’attribution : Du point de vue des mandants, il peut être utile d’inviter de manière ciblée des instituts avec lesquels la collaboration a déjà fait ses preuves. Une telle procédure est agréable pour ces instituts. Mais elle limite la concurrence et rend plus difficile l’entrée de nouveaux évaluateurs et nouvelles évaluatrices sur le terrain. Si l’appel d’offres est plus large, le travail d’évaluation des offres risque d’augmenter, mais les nouveaux évaluateurs et nouvelles évaluatrices enrichissent la concurrence et ont ainsi l’occasion de se montrer et de faire leurs preuves.

Pistes d’action

Dans le temps imparti, les approches suivantes, qui favorisent une bonne collaboration entre les mandants et les évaluateurs/-trices, ont été abordées :

- Des attentes claires et transparentes dans les appels d’offres, tout en laissant une marge de manœuvre pour que les évaluateurs puissent apporter leur expertise méthodologique de manière appropriée.

- Permettre les questions, bien documenter les clarifications et les rendre accessibles à toutes les personnes intéressées.

- Donner aux nouveaux instituts d’évaluation la possibilité de se présenter, que ce soit dans le cadre d’appels d’offres publics, de manifestations spécifiques pour les instituts d’évaluation ou d’entretiens de présentation bilatéraux, et/ou encourager les consortiums.

- Organiser des procédures sélectives à plusieurs niveaux afin de donner les mêmes chances aux instituts d’évaluation tout en limitant les dépenses.

- Utiliser des panels d’évaluation lors de l’évaluation des offres.

- Accorder explicitement une grande importance aux compétences d’évaluation lors de l’évaluation des offres.

- Permettre des designs adaptatifs afin que l’évaluation puisse être adaptée aux évolutions de l’objet de l’étude.

- Justifier les refus de manière détaillée et compréhensible en se référant aux directives et aux critères d’évaluation.

- Indiquer explicitement dans les offres les rôles des évaluateurs/trices impliqué·e·s.

Conclusion

Cette deuxième manifestation a également montré l’importance du dialogue entre les mandants et les évaluateurs/-trices, au-delà des rapports de mandat concrets. Le dialogue permet aux ‘nouveaux’ évaluateurs de se faire connaître sur le terrain. Mandants et évaluateurs/-trices peuvent faire connaissance et discuter ouvertement. Un dialogue constructif a eu lieu sur les expériences et les défis de la phase de l’appel d’offres d’une évaluation jusqu’au contrat, dans la perspective de l’autre partie, et des pistes d’action utiles ont été élaborées en commun.

Le prochain dialogue “Du contrat au rapport d’évaluation” aura lieu en novembre 2024.

Lieu : Centre de formation continue universitaire, Université de Berne, bâtiment UniS, Schanzeneckstr. 1.

Tous les participants et toutes les participantes des deux premières manifestations, mais aussi les nouveaux mandants et évaluateurs/-trices, sont cordialement invité·e·s !

Inscription à : evaluation.zuw@unibe.ch

Günter Ackermann & Stefanie Krapp (SEVAL GT Compétences)

Christian Rüefli (SEVAL GT Standards)

Groupe de travail Compétences

- Réunion de réseau 2024 du réseau DACH pour la promotion de la santé:

Une rencontre du réseau DACH pour la promotion de la santé aura lieu les 20 et 21 septembre 2024 à la ZHAW à Winterthour. Il s’agit d’un réseau ouvert auquel il est possible de participer librement. L’un des trois thèmes principaux de la rencontre de cette année est “l’évaluation dans la promotion de la santé et la prévention”. Il s’agit de faire un état des lieux (dans les pays de la région DACH – Allemagne, Autriche et Suisse) et de déterminer les synergies et les axes de développement. Les spécialistes de l’évaluation intéressés par cette vue d’ensemble et cet échange sur “l’évaluation et la recherche sur les effets dans la promotion de la santé et la prévention” peuvent s’informer et s’inscrire sur le site web de la manifestation. - Eval-training.org : la plateforme de formation et de perfectionnement en évaluation a été reprogrammée et est à nouveau pleinement opérationnelle : eval-training.org. Veuillez saisir au fur et à mesure les offres de formation et de perfectionnement à venir ! Les données des utilisateurs/-trices et les offres en cours ont été reprises, mais pas les offres déjà clôturées.

Projet de livre “Les standards d’évaluation SEVAL dans la pratique” – Appel à contributions

Les groupes de travail Recherche sur l’évaluation et Standards d’évaluation envisagent la publication de publier un livre sur la pratique de l’application des Standards SEVAL. Le livre contiendra des exemples pratiques, des prises de position ainsi que des travaux scientifiques du point de vue des différentes parties prenantes de l’évaluation. L’équipe éditoriale (Andreas Balthasar, Lars Balzer, Nicolas Grosjean, Céline Mavrot, Christian Rüefli et Reinhard Zweidler) invite toutes les personnes intéressées à soumettre des propositions de contributions au livre. Un appel à contributions détaillé est disponible ici. Les déclarations d’intention pour des contributions peuvent être envoyées jusqu’au 1er octobre 2024.

Agenda

Vous trouvez les manifestations continuellement sur notre site web

Rappel : si vous êtes membre de la SEVAL et vous souhaitez participer à l’une ou l’autre des manifestations, vous pouvez obtenir un dédommagement de vos frais de transports, d’hébergement et d’inscription (max. CHF 1’000.-) en rédigeant une note avec les enseignements tirés de la manifestation. Votre contribution sera publiée dans la SEVAL-Newsletter. Merci de vous dresser à l’avance au secrétariat SEVAL secretariat@seval.ch.

Publications

La rubrique publications offre une plate-forme pour rendre le public intéressé attentif à des nouvelles parutions dans le domaine d’évaluation ou à des publications des membres de la Seval (rapports d’évaluation, livres, articles dans des livres ou revues spécialisées etc.). Indications peuvent à tout moment être adressées à la rédaction : secretariat@seval.ch