Editorial

Die Arbeitsgruppen sind der Antrieb der SEVAL. Ihre zahlreichen Aktivitäten zeugen von ihrer Dynamik. In diesem Newsletter finden Sie inspirierende Berichte über die Ereignisse der letzten Monate. Ausserdem finden Sie ein Porträt des ersten Gewinners des Stipendiums zur Förderung des Nachwuchses in der Evaluation.

Der Jahreskongress ist die wichtigste Veranstaltung der SEVAL und die Gelegenheit, uns wiederzusehen. Das Organisationskomitee hat ein spannendes Programm voller Entdeckungen zusammengestellt. Im Mittelpunkt steht die Kommunikation, ein Thema, das uns alle beschäftigt, um unser Vorgehen und unsere Ergebnisse besser zugänglich zu machen. Melden Sie sich an, kommen Sie zahlreich und verbreiten Sie die Informationen in Ihrem Umfeld!

Laurent Crémieux

Vorstandsmitglied der SEVAL

Themen

- Aktivitäten und Mitteilungen der SEVAL

- Internationales

- Aus- und Weiterbildung

- Informationen aus den Arbeitsgruppen

- Agenda

- Publikationen

Aktivitäten und Mitteilungen der SEVAL

Kongress 2024: Anmeldung eröffnet

Der diesjährige Jahreskongress der SEVAL, der gemeinsam mit dem GREVAL organisiert wird, findet am 29. und 30. August statt und trägt den Titel «Image und Wahrnehmung der Evaluation. Sind wir zu technokratisch?». Schauen Sie sich das Programm an!

Die Evaluation wird nicht immer als ein Instrument zur Verbesserung des öffentlichen Handelns wahrgenommen. Wer hat nicht schon einmal gehört, Evaluationen würden viel kosten und nichts bringen? Können solche Klischees überwunden werden? Sie begründen sich anscheinend unter anderem mit einer teilweise zu technokratischen Kommunikation von Evaluierenden mit den verschiedenen Interessengruppen wie z.B. mit Zielgruppen, potenziellen Nutzern und der breiten Öffentlichkeit

Anhand von Präsentationen von Fachpersonen sowohl für Evaluation als auch für Kommunikation erörtern wir Strategien, um das Verständnis für Evaluation bei Personen ohne Fachkenntnisse in diesem Bereich zu fördern. Das Programm lässt auch Raum für Diskussionen und für Erfahrungsaustausch zwischen praktizierenden Evaluatorinnen und Evaluatoren und allen anderen Interessierten.

Der Nachmittag des 29. August beinhaltet neben den traditionellen Methodenateliers auch einen Side-Event für aufstrebende Evaluatorinnen und Evaluatoren sowie Tandem-Diskussionen zwischen jeweils einzelnen aufstrebenden und erfahrenen Evaluierenden. Das diesjährige Angebot an Ateliers ist umfangreich und vielfältig. Alle können an vier Ateliers (auf Deutsch, Französisch oder zweisprachig) teilnehmen.

SEVAL-Stipendium 2024

Das SEVAL-Stipendium zur Nachwuchsförderung geht in die zweite Runde

Nachdem das SEVAL-Stipendium letztes Jahr zum ersten Mal vergeben wurde, können sich auch dieses Jahr interessierte junge, angehende Fachleute auf das CAS- und/oder Praktikums-Stipendium bewerben.

Kennen Sie junge Nachwuchstalente? Dann zögern Sie nicht, sie zur Bewerbung auf das Stipendium einzuladen!

Mehr Informationen hier

***

SEVAL-Stipendium 2023

Gewinner des Nachwuchsstipendiums 2023

Das Nachwuchsstipendium 2023 wurde an Rasmané Sina verliehen, um ein CAS am IDHEAP zu absolvieren. Die Jury hatte rund zehn Bewerbungen erhalten.

– Rasmané Sina, was ist Ihr Werdegang?

Als Lehrbeauftragter für Wirtschaftswissenschaften an der Universität Genf beschäftige ich mich intensiv mit Fragen der Analyse von wirtschaftlichen Entwicklungspolitiken, dem Management von Projekten und Programmen und der Evaluation öffentlicher Politiken. Dabei gehe ich von meiner universitären Grundausbildung aus, die in der makroökonomischen Analyse der Entwicklung, der Wirtschafts- und Sozialpolitik und vor allem in den gemischten (quantitativen und qualitativen) Methoden, die in den Sozialwissenschaften angewandt werden, besteht.

– Warum haben Sie sich für das Stipendium beworben? Worin besteht der Mehrwert für Sie?

Meine Bewerbung für das Stipendium der Schweizerischen Evaluationsgesellschaft (SEVAL) ist aus zwei Gründen motiviert. Erstens, um Zugang zu einer sehr fortgeschrittenen und hochspezialisierten Ausbildung in Politikbewertung am renommierten Institut des hautes études en administration publique (IDHEAP) zu erhalten, und zweitens, um der SEVAL beitreten zu können, um meinen Beitrag an technischen Kompetenzen und zur Diversifizierung der Methoden der Politikbewertung sowohl in der Schweiz als auch auf internationaler Ebene leisten zu können.

– Welche Erfahrungen haben Sie mit dem CAS am IDHEAP gemacht?

Die CAS-Ausbildung ist für mich eine reiche Erfahrung mit einer Stärkung meiner Kompetenzen in der Methodik und den Techniken der Evaluation öffentlicher Politiken und der Verwaltung von Projekten und Programmen. An der Ausbildung waren auch mehrere Akteure aus dem akademischen und beruflichen Umfeld beteiligt. Dies ermöglichte eine viel professionellere und praktischere und vor allem angewandte Ausbildung mit mehreren sehr fortschrittlichen Instrumenten für eine rigorose Bewertung der öffentlichen Politik, Projekte und Programme sowohl quantitativ als auch qualitativ. Die Ausbildung konzentrierte sich auf praktische Fälle und reale Beispiele für die Evaluierung von öffentlichen Politiken, Projekten und Programmen sowohl in der Schweiz als auch auf internationaler Ebene. Sie hat mir eine gute Kenntnis der verschiedenen Evaluationsmodelle und vor allem eine gute Dosis des wissenschaftlichen Ansatzes in der Evaluation ermöglicht. Dies ermöglicht es mir, nach der Durchführung von Evaluationen von öffentlichen Politiken, Projekten und Programmen sehr relevante Empfehlungen für die Entscheidungshilfe im privaten wie auch im öffentlichen Sektor zu formulieren. Ich konnte an der praktischen Evaluierung eines Programms für internationale Zusammenarbeit und Entwicklung arbeiten.

– Wie sehen Sie Ihre Zukunft in der Schweizer Evaluationsgemeinschaft?

Eine erfüllte berufliche Zukunft in dieser Gemeinschaft. Mit dieser Ausbildung, kombiniert mit meinen Berufserfahrungen in der Projekt- und Programmevaluation, werde ich in einer sehr guten Position sein für Evaluationsmandate von internationalen Originationen für soziale, ökologische und Entwicklungsfragen. Mit der SEVAL ist es eine kontinuierliche Ausbildung mit der Berücksichtigung neuer Forschungsergebnisse zu Evaluationen öffentlicher Politiken. Dies ermöglicht eine perfekte Beherrschung nicht nur von Fragen der Evaluation von Wirtschafts- und Sozialpolitiken auf Schweizer Ebene, sondern auch von Fragen der internationalen Zusammenarbeit und Entwicklung, die auf die grossen Entwicklungsprojekte und -programme der Schweizer Politik im Ausland ausgerichtet sind. Es ist auch eine gute Gelegenheit, sich in ein großes globales Netzwerk von Fachleuten und Experten für die Evaluation von öffentlichen Politiken, Projekten und Programmen zu integrieren, um so die Expertise in der Evaluation zu stärken und aufzubauen.

Internationales

Bericht

IV. Weltforum für Evaluation

Rabat – 26., 27. und 28. Februar 2024

Das IV. Weltforum für Evaluation mit dem Titel ” Führen einer progressiven und zeitgemäßen Evaluationspraxis ” fand vom 26. bis 28. Februar in Rabat, Marokko, statt.

Das Forum wurde von der Internationalen Organisation für die Zusammenarbeit in der Evaluation (OICE) und EvalPartners in Zusammenarbeit mit der Association Marocaine d’Évaluation (AME), den UN-Organisationen sowie dem finnischen Außenministerium und dem Deutschen Institut für Entwicklungsevaluation (DeVAL) organisiert. Das Forum wurde hauptsächlich in englischer Sprache abgehalten, in geringerem Maße auch in Französisch und Arabisch.

Das IV. Weltforum für Evaluation bot EvalPartners und der globalen Evaluationsgemeinschaft die Gelegenheit, eine neue EvalAgenda 2030 zu erarbeiten, die Evaluation zu vertiefen und voranzutreiben, einschließlich der Erweiterung und Optimierung von Partnerschaften und der Umsetzung der UN-Resolution (A/RES/77/283) für die nationale Evaluierung der Ziele für nachhaltige Entwicklung (SDGs), die 2023 verabschiedet werden soll.

Am Montag fanden parallel dazu Vorforen-Workshops zu eher methodischen Aspekten statt:

- Vom Land durchgeführte Evaluation: Maximierung des Nutzens, der Verwendung und der Qualität.

- Evaluierung, um nationale Prioritäten mit den SDGs zu verknüpfen.

- Die Rolle von VOPEs (Voluntary Organizations for Professional Evaluation) bei der Förderung der UN-Resolution.

- Welche Antworten gibt es auf die methodischen Herausforderungen bei der Evaluierung öffentlicher Politiken?

- Wie lassen sich die Klippen der Standardisierung umschiffen? Methodische Grundlagen für eine größere Vielfalt in der Evaluation.

- Transformative, progressive und innovative Evaluierungspraktiken.

- Analyse von Beiträgen: Rahmen für die Evaluierung und Vermeidung von Fallstricken.

- Generative künstliche Intelligenz (GI)

Am Dienstag nahmen an der Eröffnungsplenarsitzung marokkanische Offizielle teil. Dabei ergaben sich die folgenden Hauptelemente:

- Die Bedeutung der Evaluierung für die parlamentarische Rechenschaftspflicht und die evidenzbasierte Entscheidungsfindung.

- Die Notwendigkeit eines partizipativen Ansatzes, der die Stimme der Bürgerinnen und Bürger in den Evaluierungsprozess einbezieht.

- Die Herausforderungen im Zusammenhang mit der Datenqualität und den begrenzten Ressourcen, die die Wirksamkeit der Evaluierung behindern.

- Der Wert der Institutionalisierung der Evaluierung in den Mechanismen der Regierungsführung und der Entscheidungsfindung.

- Die Verpflichtung zur kontinuierlichen Verbesserung und Anpassung von Evaluierungsmethoden, um den sich ständig ändernden Bedürfnissen gerecht zu werden.

Die Plenardiskussion befasste sich mit der Transformation der Evaluierung, um globalen und nationalen Realitäten Rechnung zu tragen. Daraus ging hervor:

- Die Wichtigkeit, systemische Ansätze und transformative Theorien des Wandels zu übernehmen.

- Die Notwendigkeit einer inklusiveren und partizipativeren Evaluierung.

- Das Potenzial von Technologie und Innovation zur Bereicherung der Evaluierung.

- Die Herausforderungen für die Transformation der Evaluation und Strategien zu ihrer Bewältigung.

- Die Chancen, die sich durch eine verstärkte internationale Zusammenarbeit und eine globale Perspektive ergeben.

Die Parallelsitzungen am Nachmittag befassten sich insgesamt mit drei Themenbereichen:

- Mehrere befassten sich mit den Zielen für nachhaltige Entwicklung:

o Evaluation der SDGs und Stärkung der Evaluierungskapazitäten der Regierung.

o Der Wert der Evaluierung in einer Welt im Wandel: Auswirkungen auf die Erreichung der SDGs im Rahmen einer ländergeführten Entwicklung.

o Nationale Evaluation der SDGs: Ein dringender Aufruf zum Handeln.

o Freiwillige nationale Prüfungen und Geschlechtergleichstellung: Wo sind die Beweise? - Eine Sitzung befasste sich mit der Rolle der Parlamentarier bei der Institutionalisierung der Politikevaluation. Sechs Jahre nach der Colombo-Erklärung befasste sich die Sitzung mit den Maßnahmen, die Parlamente auf der ganzen Welt zur Umsetzung der Colombo-Erklärung und zur Institutionalisierung der Evaluierung ergriffen haben, mit den erzielten Ergebnissen, den Herausforderungen und den gelernten Lektionen.

- Zwei Sitzungen befassten sich mit Dekolonisierung / Süd-Süd-Beziehungen:

o Dekolonisierung der Evaluierungspraxis.

o Süd-Süd-Richtlinien für eine transformative Evaluierung.

Am letzten Tag war eine Plenardiskussion über die Richtung der EvalAgenda 2030 geplant. Vertreterinnen und Vertreter von UN-Organisationen und Geberorganisationen (UNSDG, Unicef, UNFPA) und anderen internationalen Institutionen (EvalPartners, IEAC) überprüften die Rolle der Evaluation angesichts der zeitgenössischen Herausforderungen und versuchten, eine neue Richtung einzuschlagen, um einen wirksamen Beitrag zur Erreichung der SDGs zu leisten. Das Panel betonte die Dringlichkeit innovativer und handlungsorientierter Evaluationsansätze, um die globalen Bemühungen zur Erreichung der SDGs zu unterstützen.

Sowohl die Podiumsteilnehmer als auch das Forumspublikum betrachten Evaluation insgesamt nicht nur als Messinstrument und zur Unterstützung der Entscheidungsfindung, sondern vielmehr als Katalysator für Veränderungen, als Mittel, um den Stimmlosen eine Stimme zu verleihen, und als Pfeiler für den Aufbau widerstandsfähigerer und inklusiverer Gesellschaften, wofür die EvalAgenda 2030 ein Symbol darstellt.

Auch an diesem letzten Tag wurden parallel Sitzungen abgehalten:

- Eine befasste sich mit den Lehren, die aus den Erfahrungen mit der Institutionalisierung von Evaluierungskapazitäten und -funktionen auf globaler Ebene gezogen werden können.

- Eine andere versuchte, eine Bilanz nach acht Jahren seit der Einführung der SDGs zu ziehen.

- Ein Panel befasste sich mit der Frage, inwieweit ein Evaluierungsansatz Made in Africa auf andere Regionen übertragbar ist.

Eine letzte Plenumsdiskussion befasste sich mit der UN-Resolution, dem Weg zur Umsetzung und dem Handeln entsprechend der Resolution und der Rolle der verschiedenen Akteure, um diese voranzutreiben.

Schließlich befasste sich ein letztes Panel mit der Professionalisierung der Evaluation. Organisiert und moderiert von Claudine Morier, Mitglied der SEVAL, vier Jahre lang Vizepräsidentin des RFE, jetzt neue Vertreterin des RFE bei der OICE, versammelte dieses Panel Vertreterinnen und Vertreter nationaler Evaluationsverbände aus Luxemburg, dem Senegal, Marokko und Mexiko. Das Panel befasste sich mit der Notwendigkeit der Professionalisierung der Evaluation (warum) sowie mit den organisatorischen und praktischen Prozessen und Modalitäten (wie).

Es beleuchtete verschiedene Erfahrungen und gelernte Lektionen in dem für jedes Land einzigartigen Prozess hin zu einer strukturierteren und professionalisierten Evaluierung. Durch die Behandlung konkreter Beispiele und bewährter Strategien veranschaulichte das Panel die Diskussionen, die heute die Evaluationsgemeinschaft bewegen. Die Herausforderungen bei der Institutionalisierung von Evaluationskapazitäten sind zahlreich, darunter der Widerstand gegen Veränderungen, fehlende Ressourcen und die Spannung zwischen individuellen versus systemischen Fähigkeiten. Es gibt jedoch Möglichkeiten, einigen dieser Herausforderungen teilweise entgegenzuwirken, wie z.B. technologische Innovation, internationale Zusammenarbeit über Netzwerke wie insbesondere das RFE und die Förderung einer Kultur des Lernens und der kontinuierlichen Verbesserung.

Meine Meinung zum Forum

Ich nahm zum ersten Mal an diesem Forum teil, das von internationalen und UNO-Organisationen getragen wird, die EvaluatorInnen in der Entwicklungszusammenarbeit seit langem kennen.

Das erste, was mir auffiel, war, dass wir zwar über die gleiche Disziplin sprachen, teilweise die gleichen Methoden anwendeten (mit Ausnahme der quasi-experimentellen Wirkungsevaluationen, die diesem Bereich eigen sind, und anderer Methoden, die in der Schweiz kaum angewendet werden, wie zum Beispiel die Beitragsanalyse oder das Outcome Harvesting) und die gleichen Kriterien verwendeten, dass sich aber der Ansatz als sehr unterschiedlich erwies. Die Debatten waren geprägt von alarmierenden und interventionistischen Beiträgen. Die Evaluatoren in der Entwicklungszusammenarbeit sind der Ansicht, dass sie eine Rolle bei der Festlegung und Umsetzung der nationalen und internationalen öffentlichen Politik zu spielen haben und fühlen sich teilweise verantwortlich für das Scheitern bei der Erreichung der SDGs, um die sich die gesamte Veranstaltung drehte.

Zweitens war die geringe Beteiligung (ca. 100 Teilnehmer/innen) der Veranstaltung nicht angemessen. An europäischen oder afrikanischen Konferenzen nehmen beispielsweise vier- bis fünfmal so viele Menschen teil. Dies ist unter anderem auf Finanzierungsschwierigkeiten zurückzuführen, die einen Wandel verdeutlichen, der in den letzten Jahren auf globalerer Ebene bei vielen regionalen und internationalen Organisationen zu beobachten war. Dies hat zu einer gewissen Isolation sowie zu einer Unsichtbarmachung der VOPEs geführt.

Letztendlich war meine Teilnahme dennoch eine Bereicherung. Auch wenn Vergleiche nicht gerechtfertigt sind, ist das frankophone Evaluationsnetzwerk auf allen Ebenen gestärkt worden. Die Fähigkeit des RFE, Schlüsselpersonen zu mobilisieren, seine Professionalität bei der Organisation des Internationalen Frankophonen Evaluationsforums und der Mehrwert der für seine Mitglieder entwickelten Instrumente, wie das Diagnoseinstrument im Bereich der Professionalisierung, zeigen die Relevanz des Engagements der SEVAL in diesem Netzwerk. Es liegt auf der Hand, dass die Zusammenarbeit mit Partnern aus demselben Sprachraum die Dinge erleichtert, auch wenn die kulturellen Unterschiede zwischen den drei im RFE zusammengeschlossenen Kontinenten enorm sind. Die Zusammenarbeit auf globaler Ebene ist in der Tat noch schwieriger und ehrgeiziger, und die Teilnahme an einer solchen Veranstaltung ist wahrscheinlich eher für Personen gedacht, die in der Entwicklungsevaluation tätig sind.

Claudine Morier

Mitbegründerin von laoulia

Die Webseiten der Evaluationsgesellschaften in der Schweiz und weltweit finden Sie hier

Aus- und Weiterbildung

Einladung zu öffentlichen Veranstaltungen im Rahmen des International Program for Development Evaluation Training (IPDET) an der Universität Bern

Das renommierte internationale Fortbildungsprogramm in Evaluation wird vom 15. bis 26. Juli 2024 an der Uni Bern stattfinden. Wir erwarten über 180 Teilnehmende aus ca. 65 Ländern, die gemeinsam zu den Grundlagen in Evaluation und zu aktuellen Evaluationsthemen lernen, sich austauschen und networken. Interessierte sind herzlich zu folgenden öffentlichen Veranstaltungen eingeladen:

15.7., 9:00-10:30h: IPDET Opening

Der Stadtpräsident, Alec von Graffenried, wird das IPDET onsite Programm 2024 offiziell eröffnen. Erfahren Sie mehr zu den Teilnehmenden und zum Core Course on Fundamentals of Evaluation, mit dem das Programm startet. In der anschliessenden Kaffepause besteht die Möglichkeit des Kennlernens und des Austauschs mit den Teilnehmenden und Dozierenden.

17.7., 18:30-19:30h: Impact Happy Hour

Informeller Austausch organisiert von Coopération Globale: Starke Armutsbekämpfung – starke Schweiz (cooperationglobale.ch) zu Evaluation und Wirkungsmessung über die Entwicklungszusammenarbeit hinaus. Diskussion zu Hürden, Best Practices und Unterstützungsmöglichkeiten durch Coopération Globale.

24.07., 14:00-15:00h: Fishbowl Discussion on the Institutionalisation of Evaluation in a Global Perspective – Results from Europe, North- and South America, and Asia

Im Anschluss Kaffee und Kuchen im Garten und IPDET World Exhibition mit Items aus den verschiedenen Kulturen und Ländern der Teilnehmenden.

25.07., 19:00-20:00h: Open Forum on Evaluating Humanitarian Action organized by the Ukrainian Evaluation Association (UEA) and the Active Learning Network for Accountability and Performance in Humanitarian Action (ALNAP).

Schauen Sie vorbei, diskutieren Sie mit und erleben den einmaligen Spirit von IPDET!

Ort: Universität Bern, Zentrum für universitäre Weiterbildung, Gebäude UniS, Schanzeneckstr. 1, Auditorium S003, Bern

Kontakt: Dr. Stefanie Krapp, Head of IPDET, stefanie.krapp@unibe.ch

Der nächste CAS Evaluation startet im März 2025

am Zentrum für universitäre Weiterbildung (ZUW) der Universität Bern!

Absolventinnen und Absolventen des CAS Evaluation 2023 beim Abschlusstag

Der CAS Evaluation richtet sich an Personen, die Evaluationen in Auftrag geben oder das Management von Evaluationen verantworten. Struktur, Inhalte und didaktische Formate wurden für die Durchführung 2025 überarbeitet. Behandelt werden grundlegende Fragen wie, was ist Evaluation und wodurch zeichnet sie sich gegenüber anderen Ansätzen aus, welche Schritte beinhaltet eine Evaluation und was gehört zum Management von Evaluationsprojekten, was sind Wirkungsmodelle und welche Rolle spielen sie bei Evaluationen, welche Designs und Erhebungsmethoden können bei Evaluationen eingesetzt werden, was macht eine gute Evaluation aus und wie kann deren Nutzung befördert werden?

Der CAS Evaluation dauert ein Jahr (März 2025 bis März 2026), umfasst 7 Module und einen Abschlusstag. Es werden 15 ECTS-Punkte vergeben. Die CAS Arbeit ist auf einen möglichst hohen praktischen Anwendungsnutzen für die Teilnehmenden ausgerichtet.

Weitere Informationen und Anmeldung: HIER

Kontakt: Dr. Stefanie Krapp, Bereichsleitung Evaluation am ZUW, stefanie.krapp@unibe.ch

Nachwuchsevaluator:innen: Die SEVAL vergibt gemeinsam mit dem ZUW ein Stipendium für die Teilnahme am CAS: Stipendium – SEVAL

Das sagen Absolvent:innen des CAS 2023:

«Im CAS haben wir den Evaluationsprozess aus unterschiedlichen Perspektiven beleuchtet und die Umsetzung der theoretischen Grundlagen in die konkrete Praxis erlernt. So kann ich das Gelernte direkt in meiner Arbeit anwenden», Julia Rickenbacher, interface

«Alle wollen Wirkung, und doch begnügen sich die meisten mit guter Hoffnung statt Evidenz. Der CAS-Kurs hat mir Wege gezeigt, der Wirkung nachzuspüren», Philip Gehri, DVIGS

Weiterbildungskurs im flipped classroom Format zu den

Grundlagen von Evaluationen für die eigene Berufspraxis, 31.10., 21.11., 12.12.2024

Zentrum für universitäre Weiterbildung (ZUW) der Universität Bern in Kooperation mit der Eidgenössischen Hochschule für Berufsbildung (EHB)

Evaluationen – jenseits von Ritualen, automatisierten Kontrollmechanismen und standardisierten Qualitätsmanagementprozessen – bringen hohen Nutzen z. B. für Entwicklungs-, Lern- und Lehrprozesse. Der Kurs zeigt auf, wie dieses Versprechen durch seriöse und realistische Evaluationsplanung, abgestimmt auf spezifische Bedürfnisse und Informationsinteressen, eingehalten werden kann.

Der Kurs folgt dem didaktischen Konzept des «inverted classroom» (flipped classroom). D.h. die Inhalte werden zuhause erarbeitet, die praktische Anwendung erfolgt an den 3 Präsenztagen. Der Kurs ist für den CAS Evaluation anrechenbar.

Weitere Informationen und Anmeldung: HIER

Dozierende: Prof. Dr. Lars Balzer, Dr. Veronique Eicher (EHB)

Kontakt: Dr. Stefanie Krapp, Bereichsleitung Evaluation am ZUW, stefanie.krapp@unibe.ch

The International Program for Development Evaluation Training (IPDET) at the University of Bern

This is IPDET

The International Program for Development Evaluation Training (IPDET) is an executive training program that aims to provide decision makers, managers and practitioners with the tools and skills to commission, manage and implement policy, program or project evaluations at local, national, regional, and global levels as well as to use those evaluations for decision-making. IPDET sets a great focus on practice and provides a diversified approach for audiences from different organizations and sectors who play different roles in the evaluation process. This is unique in the evaluation training sector and gives the participants differentiated perspectives on evaluation and connects individuals worldwide.

The program is a collaborative effort between three partners: The Center for Continuing Education (ZUW) at the University of Bern, Switzerland, the Center for Evaluation (CEval) in Saarbrücken, Germany, and the Independent Evaluation Group of the World Bank (IEG). This partnership brings long-standing roots in development evaluation and training as well as strong faculty with on-the-ground experience.

Since 2021, IPDET is a core implementing partner of the Global Evaluation Initiative (GEI) and receives funds especially for scholarships and Global Outreach activities from GEI funding partners. GEI is an inclusive global partnership committed to developing country-owned, sustainable monitoring and evaluation (M&E) frameworks and capacities to promote the use of evidence in public decision-making, enhance accountability, and achieve better results.

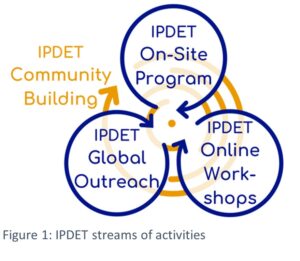

Based on IPDET´s Evaluation Capacity Development Strategy, IPDET consists of three different streams of capacity building activities, which are framed by overarching community building activities:

On-Site Program | Bern, Switzerland | Fundamentals of evaluation are taught during the one-week Core Course, followed by one week of consolidation and specialized workshops. Furthermore, due to its onsite character, it is a central networking place for the IPDET Community.

Online Workshops | Adapting to the constrains of the Covid-19 pandemic IPDET developed an online program stream in 2020. Each workshop is conducted throughout one week and covers a specialized evaluation topic. The online workshops combine synchronous and asynchronous learning.

Global Outreach | Since 2021 IPDET is expanding its activities across the globe, guided by its IPDET’s Global Outreach Strategy, ensuring that trainings and guidance can better be tailored to the needs of specific audiences in different regions. The activities are both, demand and supply driven and target decision makers and practitioners in national governments, civil society and development organizations, parliamentarians and their scientific staff, trainers for evaluation, and young and emerging evaluators.

Community Building | To strengthen and connect the community, IPDET engages the onsite participants in specific networking activities and implements online activities, like the Kick-Off and Closing Event, social gatherings, and technical tools, like the IPDET Listserv, the IPDET eLearning platform, and the IPDET CoSMOS (Community server – a memorable online society).

IPDET`s 2023 participants

Participation numbers | The IPDET On-Site program 2023 attracted 171 individuals in total, 76 of them have been awarded a scholarship. During the first week, a total of 119 participants attended the Core Course and for the second week IPDET welcomed 146 participants who attended one to two workshops.

Countries and regions | Participants coming from ‘Europe and Central Asia’ accounted for the highest attendance share during the entire On-Site program (35%), and especially during the workshop week. In the Core Course they were closely followed by participants from Sub-Saharan Africa.

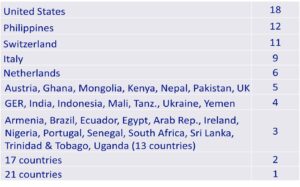

Participants came from 70 different countries:

Table 1: Countries with highest attendance in 2023 (onsite and online)

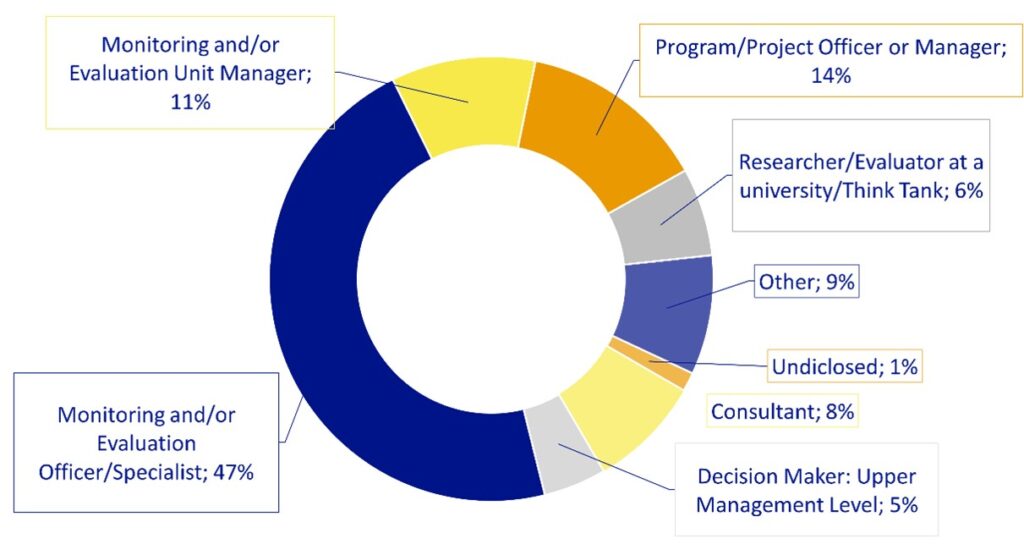

Job Position in M&E | Regarding the job position that participants held at the time of the On-Site program it can be stated that half of the participants worked as ‘M&E Officers or Specialists’, while the second largest category was represented by those working as a ‘Program/Project Officer or Manager’ (14%). The third largest group was ‘M&E Unit Managers’ (11%). A small proportion of the overall participants reported working as a ‘Consultant’ (8%) or a ‘Researcher/Evaluator at a University/Think Tank’ (6%), and even fewer participants (only 5%) indicated to be working as ‘Decision Maker at the Upper Management Level’.

Figure 2: Job positions of participants

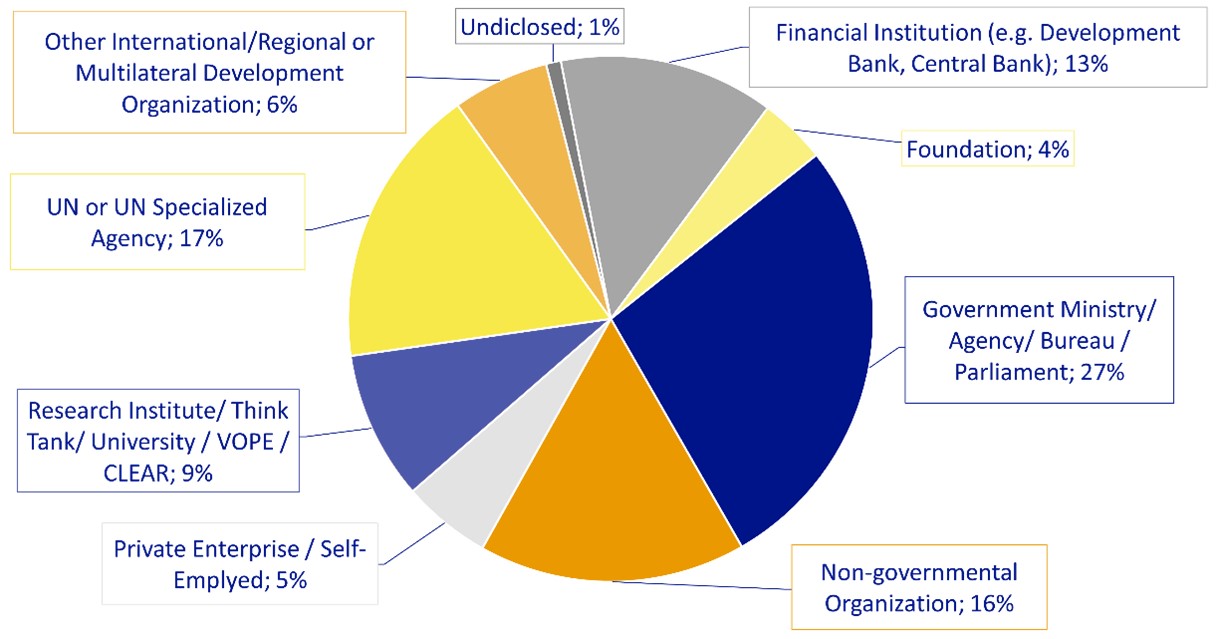

Type of organization | 27% of participants worked for the ‘Government, Ministry, Agency or Bureau’, representing the largest categorical group; followed by those from an ‘UN/UN specialized agency’ (17%), a ‘Non-governmental organization’ (16%), and a ‘Financial institution‘ (13%).

Figure 3: Types of organizations participants are working for

IPDET`s take aways and plans to utilize the gained knowledge

And or enroll in this year`s online workshop:

More information: International Program for Development Evaluation Training | IPDET

Contact: Dr. Stefanie Krapp, Head of Program, stefanie.krapp@unibe.ch

Weitere Veranstaltungen finden Sie auf unserer SEVAL-Webseite

Informationen aus den Arbeitsgruppen

SEVAL Erfahrungsaustausch zur Wirksamkeit der internationalen Zusammenarbeit

29. Februar 2024 am Zentrum für universitäre Weiterbildung (ZUW) der Uni Bern

Die SEVAL Arbeitsgruppen Internationale Zusammenarbeit und Kompetenzen haben gemeinsam mit der Eidgenössischen Finanzkontrolle (EFK) am 29.02.2024 einen spannenden Austausch organisiert mit:

- Dr. Jörg Faust, Direktor des Deutschen Evaluierungsinstitutes der Entwicklungszusammenarbeit (DEval)

- Simone Ledermann, Leiterin der Parlamentarischen Verwaltungskontrolle der Schweiz (PVK)

- Silvana Hogg, Leiterin der Fachstelle Evaluation und Controlling der DEZA

- Reto Thönen, Fachstelle Evaluation und Controlling der DEZA

- Stefanie Krapp, Leiterin des International Program for Development Evaluation Training (IPDET) der Uni Bern

Die hohe Zahl an Teilnehmenden an der Veranstaltung mit 45 Personen zeigt das grosse Interesse am Thema Wirksamkeit der IZ.

Von links nach rechts: Stefanie Krapp (IPDET / Uni Bern), Jörg Faust (DEval), Silvana Hogg (DEZA), Simone Ledermann (PVK), Reto Thönen (DEZA), Kimon Schneider (NADEL ETHZ), Mathias Rickli (EFK), Laurent Cremieux (SEVAL / EFK).

1. Die Rolle des Deutschen Evaluierungsinstituts der Entwicklungszusammenarbeit (DEval)

Nach der Begrüssung des SEVAL Vorstandsvertreters Laurent Cremieux und der Einführung durch Stefanie Krapp (ZUW/Uni Bern) und Mathias Rickli (EFK), hat Jörg Faust in einem Inputreferat zur Entstehung, den Zielen und dem Zweck des DEval und seinem Nutzen für die Öffentlichkeit berichtet. Das DEval wurde 2012 vom Bundesministerium für wirtschaftliche Zusammenarbeit und Entwicklung (BMZ) gegründet. Kernaufgabe des DEval ist es, die Aktivitäten der deutschen Entwicklungszusammenarbeit zu analysieren und zu bewerten – unabhängig, praxisorientiert und auf der Grundlage wissenschaftlicher Erkenntnisse. Damit agiert das Institut an der Schnittstelle von Politik, Wissenschaft und Praxis mit dem übergeordneten Ziel, der Entwicklungszusammenarbeit nützliche Evidenz zur Verfügung zu stellen. Eine weitere Aufgabe besteht darin, die vorhandenen Methoden und Standards der Evaluierung weiterzuentwickeln, um die Evaluierungspraxis zu verbessern. Zudem arbeitet das DEval daran, die Evaluierungskapazitäten in den Partnerländern der deutschen Entwicklungszusammenarbeit zu stärken. Nicht zuletzt unterstützt es die Verbreitung des in den Evaluierungen generierten Wissens. Dadurch sollen Lernprozesse gefördert und Entscheidungen in der Entwicklungszusammenarbeit erleichtert werden. Die Präsentation von Jörg Faust befindet sich hier. Weitere Informationen zum DEval finden sich hier.

Möglichkeiten und Grenzen der Wirkungsmessung in der IZA sieht Jörg Faust über folgende 4 Hauptaspekte beeinflusst:

- Auf der Angebotsseite bestehen grundsätzlich sehr viele Möglichkeiten der Wirkungsmessung, zunehmend insbesondere durch anspruchsvolle Methoden bzw. deren Kombination und auch den Einsatz neuer Technologien (Big Data, KI, etc.). Entscheidend wird sein inwieweit Evaluierungseinheiten die Ressourcen (Zeit, Humankapital, Finanzen, Organisationskapital) hierfür haben bzw. bekommen bzw. entwickeln können.

- Auf der Nutzungsseite hängt sehr viel von den institutionellen Rahmenbedingungen ab, welche die Nutzung unabhängiger und nützlicher Evidenz beeinflussen (Evaluierungsstandards, Evaluierungsprozess, Einspeisung und Umsetzung von Empfehlungen).

- Sowohl auf der Angebots- wie auch auf der Nutzungsseite wird Evaluierung zunehmend einem Spagat zwischen stärkeren Forderungen nach Partnerorientierung aber auch der Orientierung an den Interessen der Geberländer ausgesetzt sein.

- Zunehmende Konkurrenz: Die Evaluierung ist ein Anbieter auf dem hart umkämpften Markt der Evidenz

Jörg Faust (DEval)

2. Evaluation der Wirksamkeitsmessung der Schweizer IZA

Im Januar 2022 beauftragten die Geschäftsprüfungskommissionen der eidgenössischen Räte (GPK) die Parlamentarische Verwaltungskontrolle (PVK), die Wirksamkeitsmessung in der IZA zu evaluieren. Die PVK untersuchte die Wirksamkeit der IZA nicht selbst, sondern befasste sich vielmehr mit der Art und Weise, wie die drei für die IZA zuständigen Verwaltungseinheiten – die Direktion für Entwicklung und Zusammenarbeit (DEZA), das Staatssekretariat für Wirtschaft (SECO) und die Abteilung Frieden und Menschenrechte (AFM) – die Wirksamkeit ihrer Interventionen anhand von Evaluationen messen und darüber Rechenschaft ablegen.

Simone Ledermann hat zur Ausgangslage, der methodischen Herangehensweise und den Ergebnissen dieser PVK Evaluation berichtet:

Die Evaluation hat auf 3 Aspekte fokussiert: 1) Qualität der Evaluationen und Hilfsmittel, 2) Nutzung der Evaluationen für Steuerung und Rechenschaftslegung, 3) Kosten der Evaluationen.

- Zu 1) Die Stärken der Qualität liegen auf den Pflichtenheften und den Zusammenfassungen und Schlussfolgerungen der Berichte, was nützlich für die Steuerung ist. Schwächen liegen bei der Darstellung der Methoden und Resultate der Berichte, was problematisch für die Rechenschaftslegung ist.

- Zu 2) Unabhängige Evaluationen zu übergeordneten Themen werden für die strategische Steuerung genutzt, hier erfolgt eine systematische Nachverfolgung der Empfehlungen. Wogegen externe Evaluationen von Projekten zwar für die operative Steuerung der Aktivitäten genutzt werden, aber ohne systematische Nachverfolgung der Empfehlungen. Aussagen, ob Ziele der IZA-Strategie erreicht werden, sind nicht möglich, denn externe Evaluationen messen Zielerreichung nicht explizit und es gibt keine systematische Bilanz im Schlussbericht.

- Zu 3) Die Kosten der Evaluation werden insgesamt als transparent bewertet. Aber weniger als 2,5 % der Projektkosten werden durchschnittlich für eine externe Evaluation aufgewendet, was im internationalen Vergleich eher tief ist. Es gibt keinen Zusammenhang zwischen der Qualität externer Evaluationen und ihren Kosten.

Die Präsentation von Simone Ledermann befindet sich hier und der PVK-Bericht ist hier veröffentlicht.

Simone Ledermann (PVK)

Silvana Hogg hat die Ansichten und Massnahmen der drei IZA-Einheiten (DEZA, SECO, AFM) zum PVK-Bericht zusammengefasst: Deren Evaluationsdienste haben selbst Qualitätslücken und Verbesserungsbedarf erkannt und erachten die Empfehlungen der PVK/GPK-S als zielführend und umsetzbar. Um die Qualität der Evaluationen zu verbessern, sollen u.a. die Zusammenarbeit der Evaluationsdienste intensiviert, Evaluationshilfsmittel überarbeitet (DEZA), Evaluationskapazitäten der Programmverantwortlichen durch Ausbildungsmodule gestärkt und die Nachverfolgung von Evaluationsempfehlungen zur Auflage gemacht werden. Eine Verbesserung der Rechenschaftslegung soll erreicht werden u.a. durch die Überprüfung der Publikationspraxis und der Methodologie der Erfolgsquote, der Einführung einer gemeinsamen Quote für DEZA/SECO, mehr ex-post Evaluationen und ein neues digitalisiertes System (DEZA), das repräsentativere und nachvollziehbarere Aussagen zur Wirksamkeit der IZA systematisch erfasst.

Die Präsentation von Silvana Hogg befindet sich hier

Silvana Hogg (DEZA)

3. Paneldiskussion zur Wirkungsmessung der IZA

In der abschliessenden Paneldiskussion moderiert von Kimon Schneider (NADEL ETHZ), tauschten sich Jörg Faust (DEval), Simone Ledermann (PVK), Reto Thönen (DEZA) und Stefanie Krapp (IPDET) gemeinsam mit dem Publikum zu spezifischen Fragen hinsichtlich der Wirkung der IZA und Rolle der Evaluation aus, u.a. was sind die Möglichkeiten und Grenzen der Wirkungsmessung in der IZA, welche Kapazitäten sind notwendig auf welchen Ebenen, wie kann das des Mikro-Makro-Paradoxon angesichts der Komplexität überwunden werden, Aktualitäten und Trends in der Evaluation von komplexen Themen (Klimafinanzierung, Digitalisierung, KI/Big Data, erforderliche Kompetenzen, etc.).

Kernelemente der Diskussion war der Hinweis, dass es für gute Wirkungsmessung methodisch eigentlich keine Grenzen gibt. Wichtig und Herausforderung zugleich sind das Vorhandensein eines «evaluative thinking» besonders in der öffentlichen Verwaltung und der erforderlichen neuen Kompetenzen, um mit BigData und KI Anwendungen umgehen zu können.

Im Weiteren wurde die Organisation der Evaluationsfunktion in Entwicklungsagenturen diskutiert. Gemäss DEval liegen klare Evidenzen vor, dass eine dezentral organisierte Evaluationsfunktion anfälliger ist für Qualitätsmängel als bei einer starken zentralen Evaluationsfunktion. Vereint waren die Panelisten in ihrem kritischen Blick auf die populäre, aber realitätsfremde politische Forderung, die Arbeit der staatlichen Entwicklungsagenturen anhand einer Erfolgsquote der durchgeführten Projekte messen zu wollen.

Die Panelisten von links nach rechts: Jörg Faust (DEval), Simone Ledermann (PVK), Reto Thönen (DEZA),

Stefanie Krapp (IPDET) und der Moderator Kimon Schneider (NADEL / ETHZ)

Für die SEVAL AG Kompetenzen: Stefanie Krapp

Für die EFK: Mathias Rickli

Für die SEVAL AG IZA: Kimon Schneider

SEVAL Dialogreihe zwischen Evaluierenden und Auftraggebenden

2.Dialogveranstaltung: „Vom Pflichtenheft zum Vertrag“

23.05.2024, 17:00-19:00h, Zentrum für universitäre Weiterbildung/Uni Bern

Veranstalter: SEVAL AGs Kompetenzen und Standards

Eine von Beginn weg gute Zusammenarbeit zwischen Evaluierenden und Auftraggebenden ist ein wichtiger Erfolgsfaktor für eine gelingende und wirkungsvolle Evaluation. Im Rahmen der SEVAL-Veranstaltung „Aus- und Weiterbildung in der Evaluation – Quo Vadis?“ im April 2022 wurde insbesondere die Qualifizierung von Auftraggebenden als dringlichen Bedarf identifiziert, um dies zu gewährleisten. Die AG Kompetenzen der SEVAL organisiert daher eine vierteilige Dialog-Reihe zur Förderung des Austauschs zwischen Auftraggebenden und Evaluierenden, zur Verbesserung ihrer Zusammenarbeit und zur Weiterentwicklung von Kompetenzen in verschiedenen Phasen einer Evaluation:

- Von der Evaluationsidee zum Pflichtenheft, 23.11.2023

- Vom Pflichtenheft zum Vertrag, 23.05.2024

- Vom Vertrag zum Evaluationsbericht, November 2024

- Vom Bericht zur Valorisierung, Frühjahr 2025

Teilnehmende und inhaltliche Foki

An der zweiten Dialogveranstaltung haben sich 11 Evaluierende und 8 Auftraggebende zu zentralen Aspekten bei Ausschreibungen und Offerten ausgetauscht, u.a.: Wie finde und erkenne ich gute Evaluator:innen, Ausschreibungsarten und -verfahren, Kommunikation während der Offertenphase, Qualität und Umfang von Offerten, Bewertungskriterien, Vertragsverhandlungen, Auftragsklärung.

Nach einem Rückblick auf die letzte Dialogveranstaltung (siehe den Werkstattbericht in LeGes 35, 2024, 1) haben die Evaluator:innen und Auftraggebenden von Evaluationen zunächst in getrennten Gruppen Herausforderungen in dieser Phase aus je ihrer Perspektive gesammelt und anschliessend perspektivenübergreifend diskutiert. Auf Basis der vielfältigen Herausforderungen wurden Spannungsfelder identifiziert und Handlungsansätze entwickelt.

Bezug zu den SEVAL Standards

Einleitend zum Dialog hat Christian Rüefli, Leiter der SEVAL Arbeitsgruppe Standards auf die SEVAL Standards mit besonderer Bedeutung in der Phase zwischen Pflichtenheft und Vertrag hingewiesen. Bei Ausschreibung und Planung einer Evaluation werden Entscheidungen getroffen und Grundlagen gelegt, die für die Qualität einer Evaluation wichtig sind. Es geht dabei darum, die Inhalte, das Konzept, die Methodik, das Vorgehen und das Projektmanagement einer Evaluation so zu gestalten, dass diese ihren Zweck bestmöglich erfüllen und den Standards möglichst gerecht werden können. Obwohl grundsätzlich alle Kriterien in jeder Phase relevant sind, gilt es in der Phase zwischen Pflichtenheft und Vertrag insbesondere die folgenden Kriterien herauszustreichen:

- A1 Ergebnisoffenheit und Unvoreingenommenheit

- A4 Nutzungsorientierung

- A6 Sicherstellung der erforderlichen Kompetenzen

- B1 Klärung von Gegenstand, Zweck, Evaluationsfragestellungen und Nutzung

- B4 Evaluationsvereinbarung

- B5 Zweckmässiges Evaluationskonzept

- C5 Dokumentation der Evaluation

Bei der Konzeption einer Evaluation können Auftraggebende und Evaluierende die Standards auf unterschiedliche Weise konkret nutzen: Auftraggebende bei der Ausschreibung, Evaluierende bei der Offerterstellung, beide Seiten beim Projektstart.

Herausforderungen in der Phase zwischen Pflichtenheft und Vertrag

Für Auftraggebende:

- Eingrenzung des Evaluationsgegenstandes

- Formulierung «guter» Evaluationsfragen, die mit dem vorhandenen Budget beantwortbar sind

- Umgang mit dem eigenen «Bauchgefühl» resp. mit der Intuition bei der Entscheidungsfindung

- Anbieter:innen ohne spezifische Evaluationskompetenz (Organisationsentwicklungsbüros, Beratungsinstitute oder Forschungseinrichtungen ohne entsprechende Spezialisierung)

- Evaluationsteams, die in der Offerte mit vielen kompetenten Mitarbeitenden vorgestellt werden, aber nicht alle in der Evaluation mitarbeiten

Für Evaluierende:

- Erwartungen der Auftraggebenden sind oft zu hoch und die Evaluationsfragen zu umfassend im Verhältnis zum gegebenen Kostendach

- Schwieriger Umgang mit impliziten Erwartungen

- Oft schwer einschätzbare Konkurrenzsituation im Offertverfahren, aber der Aufwand für die Erarbeitung von Offerten ist recht hoch

- Fehlende Kompetenzen der Auftraggebenden kann implizieren, dass bei der Beurteilung der Angebote der Preis und nicht die Qualität im Vordergrund steht

- Zu kurze Fristen zur Einreichung von Offerten

- Keine Möglichkeit der Rückfragen im Offertenprozess

- Keine kohärente Verwendung der Bewertungskriterien von Offerten

- Knappe oder inhaltlich nicht nachvollziehbare Absagen im Verhältnis zum Aufwand einer Offerterstellung

- Zurückziehen von Ausschreibungen in der Offertenphase

Spannungsfelder, die sich aus den Herausforderungen ergeben

- Vorgegebener Rahmen: Die Evaluierenden begrüssen es, wenn die Vorgaben für eine Evaluation klar sind. Während Auftraggebende mit zu geringen Evaluationskompetenzen eine Herausforderung für Evaluierende sein können, weil beispielsweise unrealistische Vorgaben gemacht werden, hat aber auch die zunehmende Professionalisierung von Auftraggebenden Schattenseiten: wenn Auftraggebende aufgrund ihrer eigenen Expertise die gewünschte Evaluation allzu detailliert ausformulieren und beispielsweise die Datenquellen, die Erhebungsmethoden, die Stichprobengrösse etc. bereits vorgegeben sind, bleibt wenig Gestaltungsspielraum. Für Evaluierende ist es wichtig, ihre Expertise in die Diskussion einbringen und selbst ein angemessenes Evaluationsdesign entwickeln und vorschlagen zu können.

- Bewertung der Offerten: Für Auftraggebende wird eine vergleichende Bewertung potenziell schwieriger, je unterschiedlicher die eingereichten Offerten sind. Andererseits ist es für Auftraggebende interessant, wenn unterschiedliche methodische Zugänge vorgeschlagen werden, aus denen ausgewählt werden kann.

- Flexibilität für Anpassungen: Es ist herausfordernd, für eine mehrjährige Evaluation bereits in der Offertenphase den Umfang von Erhebungen über die gesamte Dauer bestimmen und kalkulieren zu können, wenn noch nicht klar ist, wie sich der Evaluationsgegenstand über die Jahre entwickeln wird und welche neuen Evaluationsfragen sich dadurch ergeben. Evaluierende wünschen sich von Auftraggebenden klare Signale, dass adaptive Evaluationsansätze willkommen sind, und Hinweise darauf, wie mit diesem Spannungsfeld zwischen verbindlicher Budgetierung und Adaptivität umgegangen werden soll.

- Vergabeverfahren: Aus Sicht von Auftraggebenden kann es wertvoll sein, gezielt Institute einzuladen, mit denen es bereits bewährte Zusammenarbeiten gibt. Für diese Institute ist ein solches Vorgehen angenehm. Allerdings beschränkt es den Wettbewerb und erschwert es neuen Evaluator:innen, im Feld Fuss fassen zu können. Wenn breiter ausgeschrieben wird, steigt potenziell zwar der Aufwand für die Beurteilung der Offerten, aber neue Evaluator:innen bereichern den Wettbewerb und erhalten so eine Chance, sich zeigen und bewähren zu können.

Handlungsansätze

In der Kürze der Zeit wurden folgende Ansätze thematisiert, welche eine gute Zusammenarbeit zwischen Auftraggebenden und Evaluierenden fördern:

- Klare und transparente Erwartungen in Ausschreibungen, aber Gestaltungsspielraum lassen, damit Evaluator:innen ihre methodische Expertise angemessen einbringen können.

- Rückfragen ermöglichen und die Klärungen gut dokumentieren und allen Interessierten zugänglich machen.

- Neuen Evaluationsinstituten die Gelegenheit geben, sich zu präsentieren, sei dies im Rahmen von öffentlichen Ausschreibungen, spezifischen Anlässen für Evaluationsinstitute oder bilateralen Präsentationsgesprächen, und/oder Konsortien fördern.

- Mehrstufige, selektive Verfahren durchführen, um Evaluationsinstituten gleiche Chancen zu geben und den Aufwand trotzdem in Grenzen zu halten.

- Bei der Beurteilung von Offerten Bewertungsgremien einsetzen.

- Evaluationskompetenzen bei der Beurteilung von Offerten explizit hoch gewichten.

- Ermöglichung von adaptiven Designs, damit die Evaluation den Entwicklungen des Untersuchungsgegenstandes angepasst werden kann.

- Absagen ausführlich und mit Bezug zu den Vorgaben und Bewertungskriterien nachvollziehbar begründen.

- Explizite Angabe der Rollen der beteiligten Evaluator:innen in den Offerten.

Fazit

Auch in dieser zweiten Veranstaltung hat sich gezeigt, wie wichtig ein Dialog zwischen Auftraggebenden und Evaluierenden ist, jenseits von konkreten Auftragsverhältnissen. Der Dialog gibt ‘neuen’ Evaluierenden im Feld die Möglichkeit, sich zu zeigen. Auftraggebende und Evaluierende können sich unbeschwert kennenlernen und offen diskutieren. Ein konstruktiver Dialog zu den Erfahrungen und Herausforderungen in der Phase der Ausschreibung einer Evaluation bis zum Vertrag aus der jeweils anderen Perspektive hat stattgefunden und nützliche Handlungsansätze wurden gemeinsam erarbeitet.

Der nächste Dialog “Vom Vertrag zum Evaluationsbericht“ folgt im November 2024.

Veranstaltungsort: Zentrum für universitäre Weiterbildung, Universität Bern, Gebäude UniS, Schanzeneckstr. 1.

Es sind alle Teilnehmenden der beiden ersten Veranstaltung, aber auch neue Auftraggebende und Evaluierende herzlich eingeladen!

Anmeldung an: evaluation.zuw@unibe.ch

Günter Ackermann & Stefanie Krapp (SEVAL AG Kompetenzen)

Christian Rüefli (SEVAL AG Standards)

AG Kompetenzen

- Netzwerktreffen 2024 des DACH-Netzwerks für Gesundheitsförderung:

Am 20./21. September 2024 findet an der ZHAW in Winterthur ein Netzwerktreffen des DACH-Netzwerks für Gesundheitsförderung statt. Es handelt sich um ein offenes Netzwerk, an dem man sich frei beteiligen kann. Einer der drei Schwerpunktthemen des diesjährigen Treffens ist «Evaluation in der Gesundheitsförderung und Prävention.» Es geht um eine Standortbestimmung (in den Ländern der DACH-Region – Deutschland, Österreich und die Schweiz) und um das Bestimmen von Synergien und Entwicklungslinien. Evaluationsfachleute, die an diesem Überblick und Austausch zu «Evaluation und Wirkungsforschung in Gesundheitsförderung und Prävention» interessiert sind, können sich über die Veranstaltungswebseite informieren und anmelden. - Eval-training.org: Die Plattform für Aus- und Weiterbildung in Evaluation wurde neu programmiert und ist nun wieder voll funktionsfähig: eval-training.org. Bitte anstehende Aus- und Weiterbildungsangebote laufend erfassen! Die Nutzerdaten und die laufenden Angebote wurden übernommen, bereits abgeschlossene Angebote nicht.

Buchprojekt «SEVAL-Evaluationsstandards in der Praxis» – Aufruf für Beiträge

Die SEVAL-Arbeitsgruppen Forschung über Evaluation und Evaluationsstandards planen ein Buch zur Praxis der Anwendung der SEVAL-Standards. Das Buch soll Praxisbeispiele, Diskussionsbeiträge sowie wissenschaftliche Artikel aus Sicht verschiedener Stakeholder enthalten. Das Herausgeberteam (Andreas Balthasar, Lars Balzer, Nicolas Grosjean, Céline Mavrot, Christian Rüefli und Reinhard Zweidler) lädt alle Interessierten ein, Vorschläge für Buchbeiträge einzureichen. Ein ausführlicher Call for Papers findet sich hier. Absichtserklärungen für Beiträge können bis am 1. Oktober 2024 eingereicht werden.

Agenda

News und Veranstaltungen finden Sie fortlaufend hier

Zur Erinnerung: wenn Sie als Mitglied der SEVAL an einer Veranstaltung teilnehmen möchten und anschliessend einen kurzen Beitrag dazu veröffentlichen, welche Erkenntnisse Sie aus dieser Veranstaltung gewonnen haben, können Sie für Ihre Transportkosten, Unterkunft und Registrierung eine Entschädigung von max. CHF 1’000.- beantragen. Ihren schriftlichen Beitrag veröffentlichen wir im Newsletter. Bitte kontaktieren Sie in der Phase der Vorbereitung Ihrer Reise das SEVAL-Sekretariat secretariat@seval.ch

Publikationen

Die Rubrik Publikationen bietet eine Plattform, um auf Neuerscheinungen zum Thema Evaluation oder auf Publikationen von Seval-Mitgliedern (Evaluationsberichte, Bücher, Artikel in Büchern oder Fachzeitschriften etc.) aufmerksam zu machen. Entsprechende Hinweise nimmt die Redaktion jederzeit gerne entgegen: secretariat@seval.ch